[연재 기고] 컴퓨터 과학과 AI에 혁신적 접근, 스파이크 인공 신경망 이해하기

2023-09-19 신윤오 기자, yoshin@elec4.co.kr

뉴로모픽 하드웨어를 위한 스파이크 인공 신경망 알고리즘 연구

뉴로모픽 하드웨어는 인간 뇌의 작동 원리를 모방하여 설계된 특수한 하드웨어입니다. 고전적 컴퓨팅과는 다른 방식으로 정보를 처리하고 저장하는 기술로 저전력 및 고효율 연산을 지원합니다. 또한, 뉴런과 시냅스의 연결 구조를 모방하여 실제 뇌의 신경회로망과 유사하게 작동합니다. 그 결과 뉴로모픽 하드웨어는 병렬 처리와 패턴 인식 등의 작업을 효율적으로 수행할 수 있습니다.

스파이크 인공 신경망 알고리즘은 이러한 뉴로모픽 하드웨어를 활용하기 위한 중요한 도구 중 하나입니다. 이 신경망은 뉴런의 활동을 희박한 펄스 형태로 모델링하여 정보를 처리하는 특징을 가지고 있습니다. 이러한 펄스 기반 처리 방식은 데이터의 시간적 변화를 효과적으로 포착할 수 있습니다. 따라서 스파이크 인공 신경망은 뉴로모픽 하드웨어의 병렬 처리 및 저전력 연산 능력을 극대화하는데 이상적인 솔루션을 제공합니다.

이 글을 통해 뉴로모픽 하드웨어를 활용하기 위한 스파이크 인공 신경망과 학습 알고리즘에 대한 연구를 소개하고자 합니다.

글/ 고려대학교 주병권 교수님 연구실

최호재 (한국과학기술연구원(KIST), 고려대학교 전기전자공학부 석박통합 과정)

목 차

1. 스파이크 인공 신경망 연구의 배경과 중요성

1-1 뉴로모픽 하드웨어의 부상

1-2 스파이크 신경망의 등장

2. 스파이크 인공 신경망

2-1 스파이크 인공 신경망 구성 요소

2-1-1 스파이크 인공 신경망 뉴런 모델

2-2 스파이크 인공 신경망의 다양한 구조

2-2-1 스파이크 순환 신경망

2-2-2 스파이크 합성곱 신경망

3. 스파이크 인공 신경망 학습 알고리즘

3-1 스파이크 타이밍 의존성 학습

3-2 역전파 학습

4. 향후 발전방향

4-1 스파이크 인공 신경망 학습 알고리즘의 연구와 개발

4-2 응용분야 확장 가능성

5. 결론

6. 참고문헌

1. 스파이크 인공 신경망 연구의 배경과 중요성

1-1. 뉴로모픽 하드웨어의 부상

폰 노이만 아키텍처는 컴퓨팅 분야에서 혁신적인 발전을 주도해왔습니다. 그러나, 현대의 데이터 중심 및 복잡한 계산 작업에서는 기존의 연산 및 처리를 담당하는 중앙 처리 장치(CPU)와 메모리 간 통신을 담당하는 버스(bus) 시스템에서 병목 현상이 빈번히 발생하게 됩니다. 이러한 도전 과제를 극복하고 미래의 컴퓨팅 분야를 위한 혁신을 주도하기 위해 뉴로모픽 하드웨어(neuromorphic hardware) 기술이 각광받고 있습니다.

뉴로모픽 하드웨어는 인간 뇌의 기능과 작동 원리를 모방하여 설계된 하드웨어로, 다양한 장점을 가지고 있습니다. 이러한 장점은 폰 노이만 아키텍처의 한계를 극복하고 더 나아가 스파이킹 신경망(SNN) 알고리즘 연구와 함께 발전 가능한 방향을 제시하고 있습니다.

첫째, 뉴로모픽 하드웨어는 높은 에너지 효율성을 갖춥니다. 뇌의 신경 세포인 뉴런과 시냅스를 모방하여, 활성화된 뉴런만이 에너지를 소비하고 나머지 부분은 저전력 상태에 머물러 유지됩니다. 이로써 대규모 데이터 처리와 같은 작업에서 발생하는 에너지 소비를 현저히 낮출 수 있습니다.

둘째, 뉴로모픽 하드웨어는 병렬 처리에 유리합니다. 이는 다수의 작업을 동시에 처리하고 실시간 데이터 분석을 가능하게 합니다. 이러한 연구는 현대 컴퓨터 과학 분야에서 더 높은 수준의 성능과 에너지 효율성을 제공할 것으로 기대됩니다.

뉴로모픽 하드웨어 연구는 다양한 분야에서 지속적으로 발전할 것으로 예상되며, 인용과 협업을 통해 이 분야의 미래를 더욱 밝게 만들 것입니다. 이러한 연구는 미래 컴퓨팅 분야의 혁신적인 발전을 주도할 것으로 기대됩니다.

1-2. 스파이크 신경망의 등장

인공 신경망(ANN, Artificial Neural Network)의 발전은 컴퓨터 과학 및 인공 지능 분야에서 엄청난 성과를 이루었습니다. 그러나 기존의 인공 신경망 모델은 에너지 소비 및 실시간 데이터 처리와 같은 측면에서 한계점을 가지고 있습니다. 이러한 제약을 극복하기 위해 스파이크 인공 신경망(SNN, Spiking Neural Network)이 등장했습니다.

.jpg)

인공 신경망과 스파이크 인공 신경망의 수식적 차이는 이들의 활성화 함수에서 나타납니다. 인공 신경망은 주로 시그모이드, ReLU(Rectified Linear Unit), tanh와 같은 연속적인 활성화 함수를 사용합니다. 이 함수는 입력 값의 가중치 합을 비선형 변환하여 출력을 생성합니다. 연속적인 활성화 함수를 사용하기 때문에 신경망의 출력은 연속적이며, 그레디언트 기반 최적화 알고리즘 (예: 역전파 알고리즘)을 사용하여 훈련됩니다.

한편, 스파이크 인공 신경망은 스파이크라 불리는 이벤트 기반 활성화 함수를 사용합니다. 스파이크는 입력을 이산적인 이벤트로 변환하며, 이러한 이벤트는 시간에 따라 전달됩니다. 연속적인 출력 대신 스파이크 이벤트를 사용하는 활성화 함수를 통해 스파이크 인공 신경망은 실제 생물학적 뉴런의 작동 방식을 더욱 정확하게 모방할 수 있습니다.

인공 신경망은 대규모 데이터 처리와 패턴 인식에 뛰어난 능력을 보입니다. 이는 컴퓨터 비전, 음성 인식, 자연어 처리와 같은 다양한 분야에서 효과적으로 활용됩니다. 하지만 인공 신경망 모델은 복잡한 작업을 위해 많은 계산을 필요로 합니다. 대규모 네트워크의 경우 학습 및 추론 과정에서 상당한 계산 시간이 필요하고 높은 에너지 소비를 보이며 실시간 데이터 처리에서 한계를 보이며 실시간 데이터 처리에서 한계가 있습니다.

반면, 스파이크 인공 신경망은 인공 신경망의 단점을 극복하기 위해 등장한 중요한 기술입니다. 스파이크 인공 신경망은 활성화 함수와 이벤트 기반 처리를 통해 에너지 효율성을 극대화하고, 실시간 데이터 처리를 가능하게 합니다. 또한, 스파이크 인공 신경망은 생물학적 뉴런의 작동 원리를 더욱 정확하게 모방하여 생물학적 현실성을 지닌 인공 신경망입니다.

이러한 장점들로 인해 스파이크 인공 신경망은 인공 신경망의 한계를 극복하고 미래의 컴퓨팅 및 인공 지능 분야에서 중요한 주제로 떠오르고 있습니다. 특히, 스파이크 인공 신경망 연구는 뇌의 신경 회로와 정보 처리 메커니즘을 이해하는 데 중요한 역할을 하며, 로봇 공학, 인간-기계 인터페이스, 의학 이미징 등 다양한 응용 분야에 혁신적인 기술을 제공할 것으로 예상됩니다.

이러한 연구 중에서도 스파이크 인공 신경망 학습 알고리즘 개발은 핵심적인 주제 중 하나로 각광받고 있으며, 이는 인간의 학습 원리에 대한 통찰력을 제공하는 연구 분야로 부상하고 있습니다.

2. 스파이크 인공 신경망

스파이크 인공 신경망은 생물학적 신경계의 작동 원리와 구조에서 영감을 받아 개발된 신경망 모델입니다. 이 모델은 뇌의 뉴런 동작 원리와 시간적 특성을 기반으로 합니다. 뇌의 뉴런은 시간적으로 간격을 두고 전기 신호인 스파이크를 생성하며, 이러한 스파이크는 다른 뉴런으로 정보를 전달하고 처리하는 방식으로 작용합니다.

스파이크 인공 신경망은 이러한 생물학적 신경망의 특성을 모방하여 입력 및 출력 신호를 스파이크 형태로 처리하고 정보를 전달합니다. 이로 인해 스파이크 인공 신경망은 인공 지능의 새로운 차원을 열어주며, 그 중요성은 더욱 부각되고 있습니다.

2-1. 스파이크 인공 신경망의 구성 요소

스파이크 인공 신경망은 뉴런과 시냅스라는 핵심 구성 요소로 이루어져 있습니다. 뉴런은 입력 신호를 수신하고 내부적인 연산을 통해 스파이크라 불리는 전기 신호를 생성합니다. 각 뉴런은 입력에 대한 반응을 시간적으로 연속적인 스파이크 형태로 표현하여 복잡한 패턴을 효과적으로 처리합니다. 이때 스파이크 생성 여부와 시간적 패턴은 뉴런의 활성화 함수에 의해 결정됩니다.

시냅스는 뉴런 간의 연결을 의미하며, 스파이크 신호가 전달되는 경로입니다. 시냅스 가중치는 뉴런 간의 스파이크 전달 강도를 조절하는 역할을 합니다. 뉴런과 뉴런 사이의 시냅스 강도를 조정하여 정보의 흐름과 가중치를 학습을 통해 조절하며, 이것이 스파이크 인공 신경망의 학습 과정입니다. [1]

이러한 뉴런과 시냅스의 조합으로 SNN은 복잡한 신호 처리와 패턴 인식 등 다양한 문제를 수행합니다.

2-1-1. 스파이크 인공 신경망 뉴런 모델

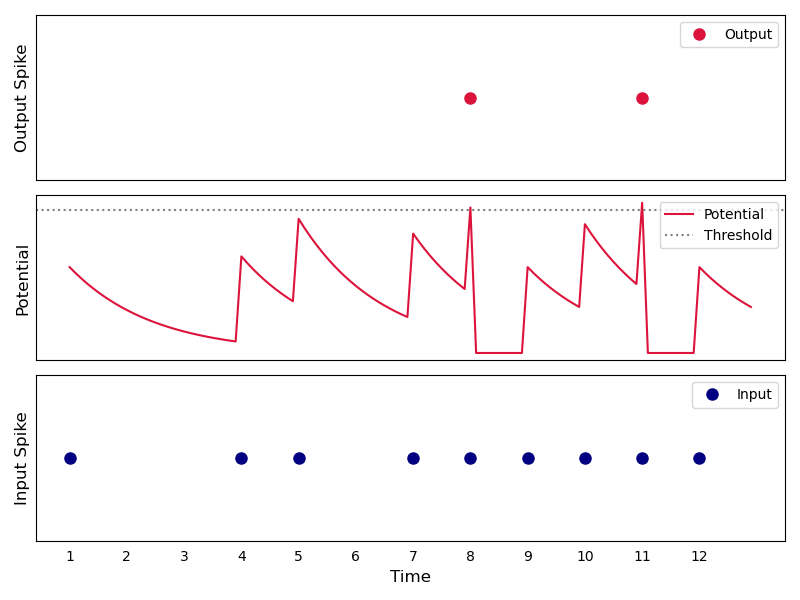

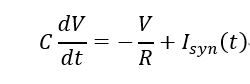

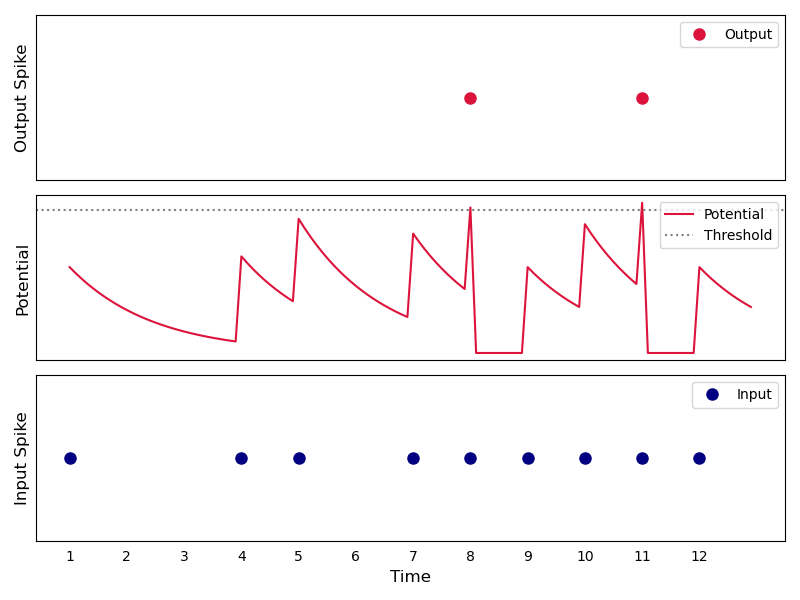

스파이크 뉴런 모델 중에서도 LIF (Leaky Integrate-and-Fire) 모델은 가장 일반적으로 사용되는 뉴런 모델 중 하나입니다. 이 모델은 그림 2와 같이 생물학적 뉴런의 동작을 간단하게 모방한 것으로, 입력 스파이크(그림 2의 Input Spike)가 뉴런의 막 전위(그림 2의 Potential)를 증가시키며, 일정한 임계값에 도달하면 스파이크를 생성(그림 2의 Output Spike)하고 막 전위를 초기화합니다.

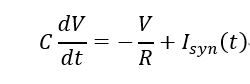

LIF 모델은 다음과 같은 수식으로 나타낼 수 있습니다.

여기서 C는 뉴런의 전기용량(Capacitance), dV/dt는 막전위 V의 시간에 대한 변화율, R은 막 전위의 시간에 따른 감쇄율을 결정하는 막 저항(Membrane Resistance)을 나타내며, Isyn (t)는 시냅스로부터의 입력 전류를 나타냅니다.

LIF 모델에서 스파이크가 생성되는 조건은 막전위 V가 일정한 임계값 Vth에 도달할 때입니다. 이를 다음과 같은 조건으로 표현할 수 있습니다.

if V(t)≥Vth then generate a spike

스파이크가 생성되면 막전위 V는 초기화되고, 스파이크의 생성 타이밍을 조절하는 휴지 기능이 포함됩니다. 이러한 LIF 모델은 시간적 패턴을 모방하고 스파이크 생성을 통해 정보 처리를 수행하는데 효과적인 수학적 모델 중 하나입니다.

2-2. 스파이크 인공 신경망의 다양한 구조

스파이크 인공 신경망은 다양한 구조로 설계되어 다양한 응용 분야에 적용됩니다. 그 중에서도 Spiking Recurrent Neural Network (SRNN)과 Spiking Convolutional Neural Network (SCNN)은 대표적인 구조로, 각각 순차적인 정보 처리와 이미지 처리에 특화되어 있습니다.

2-2-1. 스파이크 순환 신경망 (SRNN, Spiking Recurrent Neural Network)

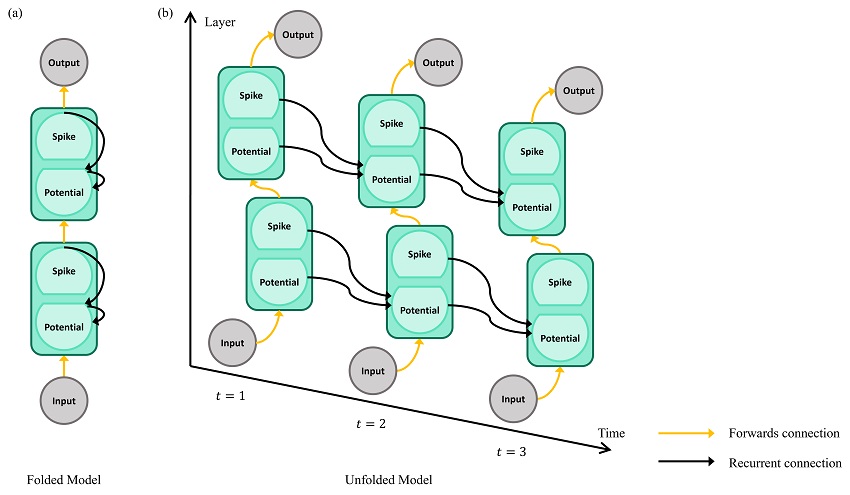

스파이크 순환 신경망은 순차적인 정보 처리에 효과적인 구조로, 시계열 데이터와 같은 입력에 적합합니다. 이 구조는 내부적으로 순환 연결을 가지며, 이전 시간 단계의 뉴런 상태를 현재 시간 단계의 입력 처리에 활용합니다. 이렇게 순환 연결을 통해 과거 정보를 유지하면서 입력 데이터를 처리할 수 있습니다. 스파이크 순환 신경망은 시계열 예측, 자연어 처리 및 제어 문제와 같은 도메인에서 유용하게 활용될 수 있습니다.

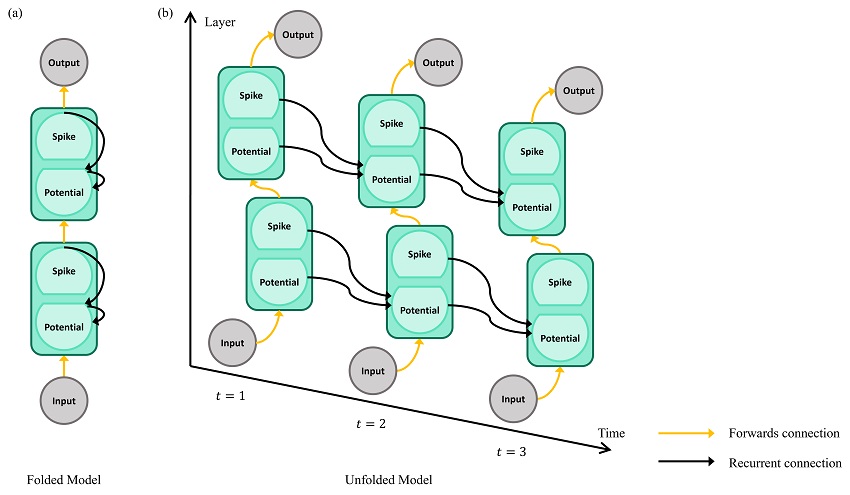

스파이크 순환 신경망은 Recurrent 모델로 분류되므로, 그림 3(a)와 같이 Folded Model로 나타내거나, 그림 3(b)와 같이 시간 축을 따라 Unfolded Model로 연결 구조를 확인할 수 있습니다. 스파이크 순환 신경망은 공간적으로 Forward connection을 가지며 동시에 시간적으로 Recurrent connection을 갖고 있습니다. 스파이크 순환 신경망의 각 Hidden 유닛은 Potential과 Spike로 구성되며, 각 Potential과 Spike는 다음 시간 단계에 영향을 미치는 구조를 가지고 있습니다. 이러한 구조는 시간적인 비선형성을 부여하며 시간적으로 복잡한 시계열 문제에 대한 우수한 성능을 보입니다. [2], [3]

2-2-2. 스파이크 합성곱 신경망(SCNN, Spiking Convolutional Neural Network)

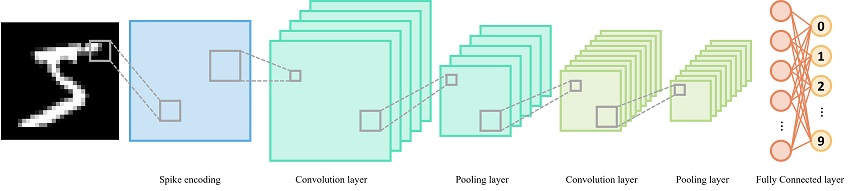

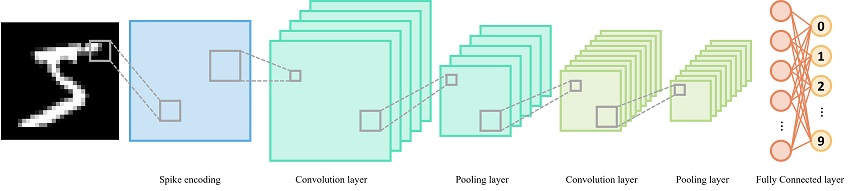

그림 4. 스파이크 합성곱 신경망 구조

스파이크 합성곱 신경망은 이미지 처리 및 패턴 인식에 특화된 구조입니다. 입력 데이터의 공간적 패턴을 탐지하고 처리하는 데 효과적인 구조입니다. 그림 4와 같이 스파이크 합성곱 신경망은 데이터를 학습할 때, Spike Encoding하여 합성곱 연산을 활용하여 입력 데이터의 지역적 패턴을 추출합니다. 이러한 과정에서 뉴런 간의 연결을 통해 전역적인 의미를 형성합니다.

스파이크 합성곱 신경망은 예시 그림 4와 같이 이미지 분류를 수행할 수 있으며 객체 감지 및 추적, 인식과 같은 컴퓨터 비전 관련 작업에 특히 적합합니다. 또한, 입력 데이터의 공간적 구조를 활용하여 정교한 패턴 분석을 수행할 수 있습니다.

3. 스파이크 인공 신경망 학습 알고리즘

스파이크 기반 학습은 입력 스파이크 패턴과 그에 따른 출력 스파이크 패턴 간의 관계를 학습하여 신경망이 원하는 작업을 수행하도록 조정하는 과정을 의미합니다. 스파이크 인공 신경망에서의 학습은 생물학적 뉴런의 작동 원리와 유사한 원리를 기반으로 하여 주로 두 가지 핵심 요소로 구성됩니다.

첫째, 시냅스의 가중치 조정입니다. 시냅스는 뉴런 간의 연결을 나타내며, 입력 스파이크와 출력 스파이크 사이의 강도를 결정하는 가중치를 조절합니다. 이 가중치 조정은 학습 알고리즘을 통해 이루어지며, 입력 스파이크 패턴이 원하는 출력 스파이크 패턴을 유도할 수 있도록 조절됩니다.

둘째, 시간적 타이밍에 관한 학습입니다. 스파이크 인공 신경망은 스파이크의 발생 시간을 고려하여 정보를 처리하며, 이를 타이밍 정보로 활용합니다. 따라서 학습 알고리즘은 입력 스파이크와 출력 스파이크의 정확한 시간적 관계를 학습하고 이를 통해 패턴을 인식하고 학습합니다.

이러한 스파이크 기반 학습은 스파이크 인공 신경망이 복잡한 신호 처리와 패턴 인식 작업을 수행하는 데 효과적으로 활용됩니다.

3-1. 스파이크 타이밍 의존성 학습 (STDP, Spike-Timing Dependent Plasticity)

스파이크 타이밍 의존성 학습은 스파이크 인공 신경망에서 가장 널리 사용되는 학습 알고리즘 중 하나입니다.[4], [5] 이 알고리즘은 두 개의 뉴런 사이의 스파이크 발생 시간 차에 따라 시냅스 강도를 조절하여 학습을 수행합니다. 스파이크 타이밍 의존성 학습은 뉴런 간의 연결 강도를 조절함으로써 스파이크의 동시성 및 순차성을 학습하는 데에 활용됩니다.

그림 5. 비지도 스파이크 타이밍 의존성 학습 (a) 뉴런 연결 구조, (b) 시냅스 강도의 상대적 변화

뉴런 A가 뉴런 B를 활성화시킨다면, A가 B의 활성화에 어떤 정도의 영향을 미쳤는지 감지하고, 만약 A가 B의 활성화에 긍정적인 영향을 미쳤다면, A에서 B로 이어지는 시냅스의 가중치를 증가시킵니다. 그러나 B가 A를 활성화한다면, B의 활성화가 A에게 어떤 영향을 미쳤는지를 감지한 후, B에서 A로 이어지는 시냅스의 가중치를 증가시킵니다. 이는 그림 5(b)와 같이 작용합니다.

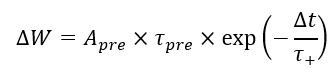

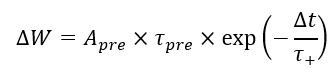

이러한 규칙을 수식으로 나타내면 다음과 같습니다. 시냅스 가중치를 W라고 할 때, 뉴런 A가 뉴런 B를 활성화시킨 경우 (A→B), 가중치 증가는 다음과 같이 나타낼 수 있습니다.

여기서 Apre는 A의 활성화의 강도, τpre는 A의 활성화 지속 시간, Δt는 B의 스파이크가 일어난 시간과 A의 스파이크가 일어난 시간의 차이, 그리고 τ+는 시냅스 강도 조정에 사용되는 시간 상수입니다.

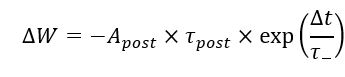

반대로 뉴런 B가 뉴런 A를 활성화시킨 경우 (B→A), 가중치 감소는 다음과 같이 나타낼 수 있습니다.

여기서 Apost는 B의 활성화의 강도, τpost는 B의 활성화 지속 시간, τ_-는 시냅스 강도 감소에 사용되는 시간 상수입니다.

스파이크 타이밍 의존성 학습은 스파이크의 타이밍에 따라 가중치를 조절하여 네트워크가 입력 스파이크 패턴을 학습하도록 합니다.

3-2. 역전파 학습 (BP, Backpropagation)

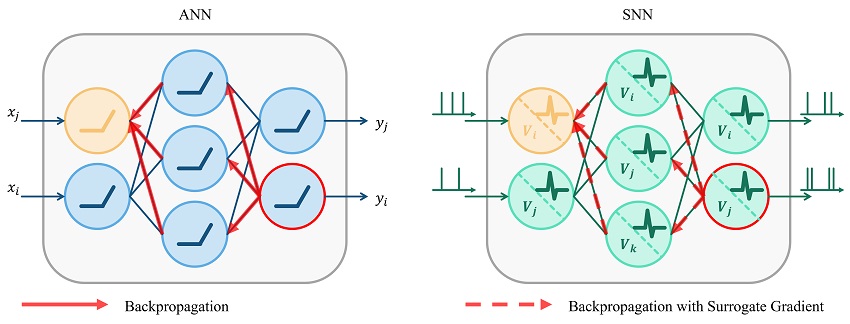

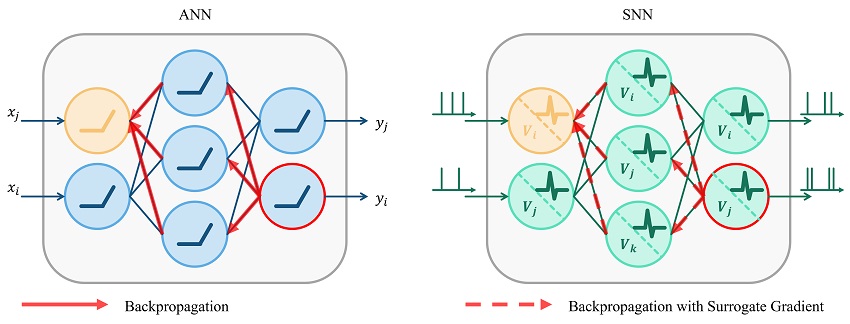

그림 6. 인공 신경망, 스파이크 인공 신경망에서의 역전파 학습 알고리즘

스파이크 인공 신경망과 인공 신경망 간의 큰 차이 중 하나는 입력과 출력의 처리 방식입니다. 인공 신경망에서는 연속적인 활성화 함수를 사용하여 연속적인 출력값을 생성하며, 이러한 연속적인 값을 다루기 위해 그림 6과 같이 그레디언트를 활용한 역전파 알고리즘을 사용하여 네트워크를 학습시킵니다. 그러나 스파이크 인공 신경망은 이산적인 스파이크 신호를 다루기 때문에 그레디언트 계산에 어려움이 있습니다.

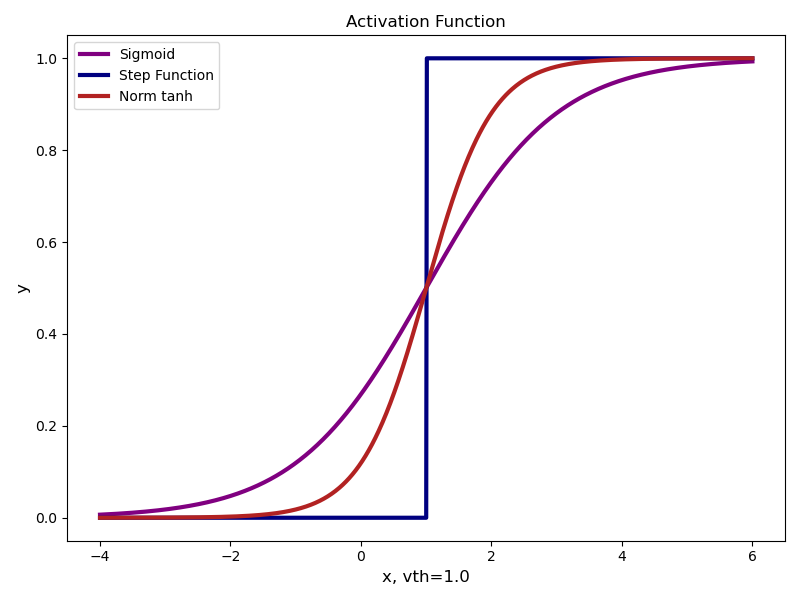

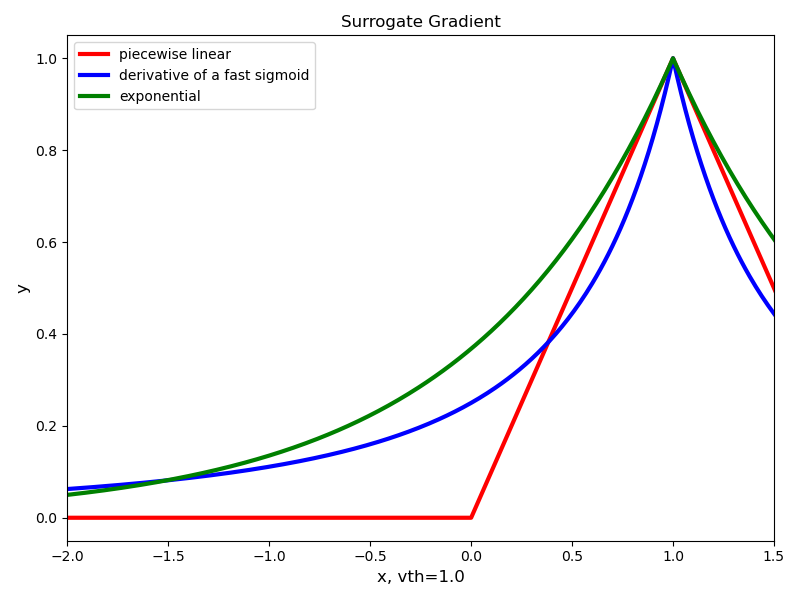

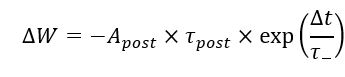

이러한 문제를 해결하기 위해 Surrogate Gradient를 활용한 역전파 알고리즘이 제안되었습니다. [6] 그림 7에서 볼 수 있듯이, 인공 신경망에서 사용하는 활성화 함수인 Sigmoid, tanh는 미분 가능성을 갖고 있지만 스파이크 인공 신경망에서 사용하는 활성화 함수인 Step function의 경우 미분 가능하지 않습니다.

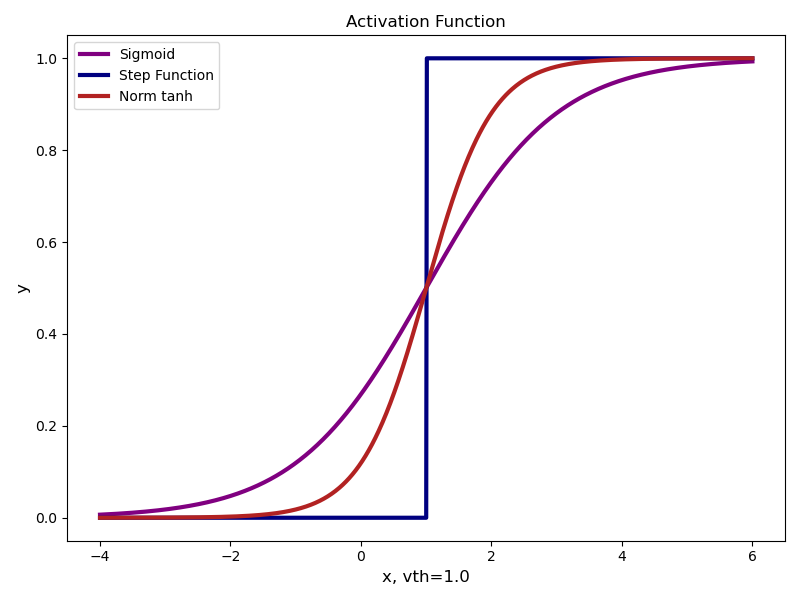

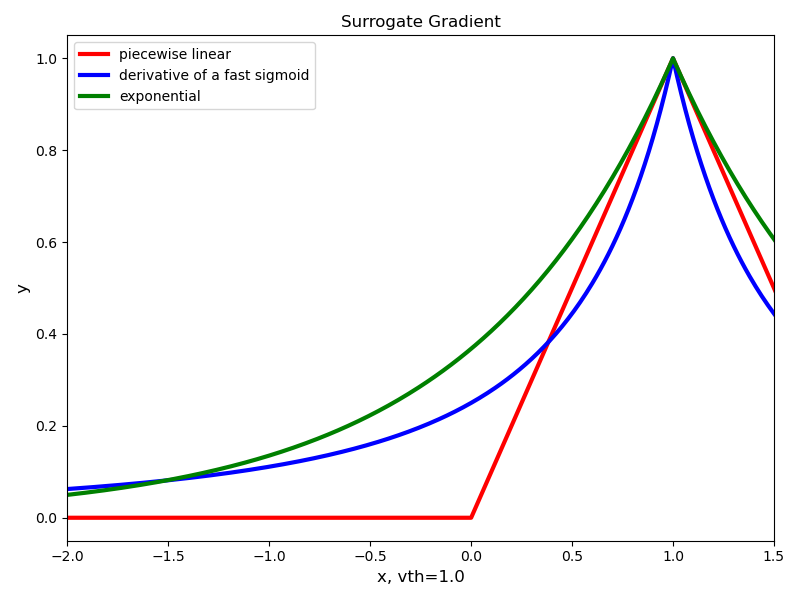

그림 8과 같이, 스파이크 신호의 불연속성을 극복하기 위해 다양한 Surrogate gradient를 활용하여 스파이크 신호와 그레디언트 사이의 관계를 설정합니다. Surrogate gradient는 연속적인 함수로 대체되는 함수로서, 이를 통해 연속적인 그레디언트 계산이 가능해집니다. Surrogate gradient를 이용한 역전파 알고리즘은 스파이크 인공 신경망의 학습을 가능하게 하며, 기존의 연속적인 역전파 알고리즘과 유사한 방식으로 신경망을 업데이트합니다.

Surrogate gradient를 사용한 역전파 알고리즘은 여전히 활발한 연구 주제 중 하나입니다. 그레디언트 근사치의 정확성과 수렴 속도 등의 측면에서 여전히 도전과제가 남아 있습니다. 따라서 스파이크 인공 신경망 학습에 이 방법을 적용하는 경우 신중한 접근과 실험을 통한 검증이 필요합니다.

4. 향후 발전 방향

스파이크 인공 신경망은 지속적인 연구와 발전을 거듭하고 있는 분야입니다. 특히, 스파이크 인공 신경망 학습 알고리즘의 연구와 개발은 스파이크 인공 신경망의 실용성을 확대하고 다양한 응용 분야에서의 활용 가능성을 확장하는 데 중요한 역할을 할 것으로 예상됩니다.

4-1. 스파이크 인공 신경망 학습 알고리즘의 연구와 개발

스파이크 인공 신경망 학습 알고리즘에 대한 연구는 현재도 끊임없이 진행 중입니다. 새로운 학습 규칙과 알고리즘, surrogate gradient를 활용한 방법 및 실시간 학습 등 다양한 연구가 개발되고 있습니다. [7], [8] 또한, 스파이크 신호를 고려하여 저전력으로 구동할 수 있으면서도 빠르고 효과적인 학습을 달성하기 위한 연구가 진행되고 있습니다. 이러한 연구들은 스파이크 신호 처리와 학습 메커니즘을 더욱 정교하게 다룰 수 있는 방향으로 나아갈 것으로 전망됩니다.

4-2. 응용 분야 확장 가능성

스파이크 인공 신경망의 응용 분야는 계속해서 확장될 것으로 전망됩니다. 현재, 스파이크 인공 신경망은 신경과학 연구를 통한 뇌 기능 모델링과 신경 질환 연구와 같은 다양한 분야에서 활용되고 있습니다. 또한, 스파이크 신호의 이산적인 특성은 실시간 데이터 처리 및 이벤트 기반 처리와 같은 분야에서도 효과적으로 활용될 수 있습니다.

스파이크 인공 신경망의 응용 분야 다변화 및 확장은 하드웨어 기술의 발전과도 밀접한 관련이 있습니다. 신경 계산 하드웨어의 발전은 스파이크 인공 신경망을 더욱 효율적으로 실행하고 실시간 처리를 가능케 하며, 따라서 스파이크 인공 신경망의 응용 분야가 다양화되고 확장되는 데 도움이 될 것으로 기대됩니다.

5. 결론

스파이크 인공 신경망은 생물학적 뉴런의 작동 원리를 모방한 혁신적인 신경망 모델로, 스파이크 신호를 활용하여 정보 처리와 학습을 수행합니다. 이러한 스파이크 인공 신경망은 뇌의 복잡한 동작 원리와 신호 전달 방식을 모방하면서도 컴퓨터 과학과 인공 지능 분야에서 혁신적인 접근을 제시하고 있습니다.

스파이크 인공 신경망을 이해하고, 뉴런 동작을 모방한 LIF 모델과 스파이크 순환 신경망, 스파이크 합성곱 신경망 등을 살펴봄으로써 SNN의 다양한 구조와 장점을 파악할 수 있었습니다. 이러한 구조들은 각각의 특성과 장점을 가지고 있어 다양한 문제에 특화된 활용 가능성을 제시하고 있습니다.

스파이크 인공 신경망 학습 알고리즘인 스파이크 타이밍 의존성 학습과 surrogate gradient를 통한 역전파 학습을 비롯하여 다양한 학습 알고리즘이 지속적으로 연구되고 있으며, 이를 통해 스파이크 인공 신경망의 학습 가능성과 효율성을 높이고 있습니다. 이러한 학습 알고리즘은 네트워크의 가중치 조정과 정보 처리에 중요한 역할을 하며, 더욱 정교한 학습 메커니즘의 개발을 향상시킬 것으로 기대됩니다.

향후에는 스파이크 인공 신경망 학습 알고리즘의 연구와 개발을 통해 더욱 정교한 학습 메커니즘을 개발하고, 스파이크 인공 신경망의 응용 분야를 더욱 확장시킬 것으로 기대됩니다. 신경과학 연구부터 실시간 데이터 처리 및 이벤트 기반 처리와 같이 다양한 분야에서의 활용은 스파이크 인공 신경망의 중요성을 더욱 부각시키고 있으며, 이러한 발전은 하드웨어 기술과의 연계를 통해 더욱 효율적인 실행과 응용 확장을 이끌 것입니다.

마지막으로, 스파이크 인공 신경망은 다양한 기술과 과학 분야의 융합을 통해 미래의 혁신적인 솔루션을 제시할 것입니다. 신경과학과 컴퓨터 과학, 인공 지능 분야와의 긴밀한 협력을 통해 스파이크 인공 신경망의 역량은 더욱 확대될 것으로 기대하며, 이러한 발전은 다음 세대의 지능적인 기술과 시스템에 기여할 것입니다.

6. 참고 문헌

[1] Eshraghian, Jason K., et al. "Training spiking neural networks using lessons from deep learning." arXiv preprint arXiv:2109.12894 (2021).

[2] Yin, Bojian, Federico Corradi, and Sander M. Boht?. "Accurate and efficient time-domain classification with adaptive spiking recurrent neural networks." Nature Machine Intelligence 3.10 (2021): 905-913.

[3] Traub, Manuel, et al. "Dynamic action inference with recurrent spiking neural networks." International Conference on Artificial Neural Networks. Cham: Springer International Publishing, 2021.

[4] Caporale, Natalia, and Yang Dan. "Spike timing?dependent plasticity: a Hebbian learning rule." Annu. Rev. Neurosci. 31 (2008): 25-46.

[5] Tavanaei, Amirhossein, and Anthony Maida. "BP-STDP: Approximating backpropagation using spike timing dependent plasticity." Neurocomputing 330 (2019): 39-47.

[6] Neftci, Emre O., Hesham Mostafa, and Friedemann Zenke. "Surrogate gradient learning in spiking neural networks: Bringing the power of gradient-based optimization to spiking neural networks." IEEE Signal Processing Magazine 36.6 (2019): 51-63.

[7] Bellec, Guillaume, et al. "A solution to the learning dilemma for recurrent networks of spiking neurons." Nature communications 11.1 (2020): 3625.

[8] Bohnstingl, Thomas, et al. "Online spatio-temporal learning in deep neural networks." IEEE Transactions on Neural Networks and Learning Systems (2022).

뉴로모픽 하드웨어는 인간 뇌의 작동 원리를 모방하여 설계된 특수한 하드웨어입니다. 고전적 컴퓨팅과는 다른 방식으로 정보를 처리하고 저장하는 기술로 저전력 및 고효율 연산을 지원합니다. 또한, 뉴런과 시냅스의 연결 구조를 모방하여 실제 뇌의 신경회로망과 유사하게 작동합니다. 그 결과 뉴로모픽 하드웨어는 병렬 처리와 패턴 인식 등의 작업을 효율적으로 수행할 수 있습니다.

스파이크 인공 신경망 알고리즘은 이러한 뉴로모픽 하드웨어를 활용하기 위한 중요한 도구 중 하나입니다. 이 신경망은 뉴런의 활동을 희박한 펄스 형태로 모델링하여 정보를 처리하는 특징을 가지고 있습니다. 이러한 펄스 기반 처리 방식은 데이터의 시간적 변화를 효과적으로 포착할 수 있습니다. 따라서 스파이크 인공 신경망은 뉴로모픽 하드웨어의 병렬 처리 및 저전력 연산 능력을 극대화하는데 이상적인 솔루션을 제공합니다.

이 글을 통해 뉴로모픽 하드웨어를 활용하기 위한 스파이크 인공 신경망과 학습 알고리즘에 대한 연구를 소개하고자 합니다.

글/ 고려대학교 주병권 교수님 연구실

최호재 (한국과학기술연구원(KIST), 고려대학교 전기전자공학부 석박통합 과정)

목 차

1. 스파이크 인공 신경망 연구의 배경과 중요성

1-1 뉴로모픽 하드웨어의 부상

1-2 스파이크 신경망의 등장

2. 스파이크 인공 신경망

2-1 스파이크 인공 신경망 구성 요소

2-1-1 스파이크 인공 신경망 뉴런 모델

2-2 스파이크 인공 신경망의 다양한 구조

2-2-1 스파이크 순환 신경망

2-2-2 스파이크 합성곱 신경망

3. 스파이크 인공 신경망 학습 알고리즘

3-1 스파이크 타이밍 의존성 학습

3-2 역전파 학습

4. 향후 발전방향

4-1 스파이크 인공 신경망 학습 알고리즘의 연구와 개발

4-2 응용분야 확장 가능성

5. 결론

6. 참고문헌

1. 스파이크 인공 신경망 연구의 배경과 중요성

1-1. 뉴로모픽 하드웨어의 부상

폰 노이만 아키텍처는 컴퓨팅 분야에서 혁신적인 발전을 주도해왔습니다. 그러나, 현대의 데이터 중심 및 복잡한 계산 작업에서는 기존의 연산 및 처리를 담당하는 중앙 처리 장치(CPU)와 메모리 간 통신을 담당하는 버스(bus) 시스템에서 병목 현상이 빈번히 발생하게 됩니다. 이러한 도전 과제를 극복하고 미래의 컴퓨팅 분야를 위한 혁신을 주도하기 위해 뉴로모픽 하드웨어(neuromorphic hardware) 기술이 각광받고 있습니다.

뉴로모픽 하드웨어는 인간 뇌의 기능과 작동 원리를 모방하여 설계된 하드웨어로, 다양한 장점을 가지고 있습니다. 이러한 장점은 폰 노이만 아키텍처의 한계를 극복하고 더 나아가 스파이킹 신경망(SNN) 알고리즘 연구와 함께 발전 가능한 방향을 제시하고 있습니다.

첫째, 뉴로모픽 하드웨어는 높은 에너지 효율성을 갖춥니다. 뇌의 신경 세포인 뉴런과 시냅스를 모방하여, 활성화된 뉴런만이 에너지를 소비하고 나머지 부분은 저전력 상태에 머물러 유지됩니다. 이로써 대규모 데이터 처리와 같은 작업에서 발생하는 에너지 소비를 현저히 낮출 수 있습니다.

둘째, 뉴로모픽 하드웨어는 병렬 처리에 유리합니다. 이는 다수의 작업을 동시에 처리하고 실시간 데이터 분석을 가능하게 합니다. 이러한 연구는 현대 컴퓨터 과학 분야에서 더 높은 수준의 성능과 에너지 효율성을 제공할 것으로 기대됩니다.

뉴로모픽 하드웨어 연구는 다양한 분야에서 지속적으로 발전할 것으로 예상되며, 인용과 협업을 통해 이 분야의 미래를 더욱 밝게 만들 것입니다. 이러한 연구는 미래 컴퓨팅 분야의 혁신적인 발전을 주도할 것으로 기대됩니다.

1-2. 스파이크 신경망의 등장

인공 신경망(ANN, Artificial Neural Network)의 발전은 컴퓨터 과학 및 인공 지능 분야에서 엄청난 성과를 이루었습니다. 그러나 기존의 인공 신경망 모델은 에너지 소비 및 실시간 데이터 처리와 같은 측면에서 한계점을 가지고 있습니다. 이러한 제약을 극복하기 위해 스파이크 인공 신경망(SNN, Spiking Neural Network)이 등장했습니다.

.jpg)

그림 1. 인공 신경망, 스파이크 인공 신경망 모델

인공 신경망과 스파이크 인공 신경망의 수식적 차이는 이들의 활성화 함수에서 나타납니다. 인공 신경망은 주로 시그모이드, ReLU(Rectified Linear Unit), tanh와 같은 연속적인 활성화 함수를 사용합니다. 이 함수는 입력 값의 가중치 합을 비선형 변환하여 출력을 생성합니다. 연속적인 활성화 함수를 사용하기 때문에 신경망의 출력은 연속적이며, 그레디언트 기반 최적화 알고리즘 (예: 역전파 알고리즘)을 사용하여 훈련됩니다.

한편, 스파이크 인공 신경망은 스파이크라 불리는 이벤트 기반 활성화 함수를 사용합니다. 스파이크는 입력을 이산적인 이벤트로 변환하며, 이러한 이벤트는 시간에 따라 전달됩니다. 연속적인 출력 대신 스파이크 이벤트를 사용하는 활성화 함수를 통해 스파이크 인공 신경망은 실제 생물학적 뉴런의 작동 방식을 더욱 정확하게 모방할 수 있습니다.

인공 신경망은 대규모 데이터 처리와 패턴 인식에 뛰어난 능력을 보입니다. 이는 컴퓨터 비전, 음성 인식, 자연어 처리와 같은 다양한 분야에서 효과적으로 활용됩니다. 하지만 인공 신경망 모델은 복잡한 작업을 위해 많은 계산을 필요로 합니다. 대규모 네트워크의 경우 학습 및 추론 과정에서 상당한 계산 시간이 필요하고 높은 에너지 소비를 보이며 실시간 데이터 처리에서 한계를 보이며 실시간 데이터 처리에서 한계가 있습니다.

반면, 스파이크 인공 신경망은 인공 신경망의 단점을 극복하기 위해 등장한 중요한 기술입니다. 스파이크 인공 신경망은 활성화 함수와 이벤트 기반 처리를 통해 에너지 효율성을 극대화하고, 실시간 데이터 처리를 가능하게 합니다. 또한, 스파이크 인공 신경망은 생물학적 뉴런의 작동 원리를 더욱 정확하게 모방하여 생물학적 현실성을 지닌 인공 신경망입니다.

이러한 장점들로 인해 스파이크 인공 신경망은 인공 신경망의 한계를 극복하고 미래의 컴퓨팅 및 인공 지능 분야에서 중요한 주제로 떠오르고 있습니다. 특히, 스파이크 인공 신경망 연구는 뇌의 신경 회로와 정보 처리 메커니즘을 이해하는 데 중요한 역할을 하며, 로봇 공학, 인간-기계 인터페이스, 의학 이미징 등 다양한 응용 분야에 혁신적인 기술을 제공할 것으로 예상됩니다.

이러한 연구 중에서도 스파이크 인공 신경망 학습 알고리즘 개발은 핵심적인 주제 중 하나로 각광받고 있으며, 이는 인간의 학습 원리에 대한 통찰력을 제공하는 연구 분야로 부상하고 있습니다.

2. 스파이크 인공 신경망

스파이크 인공 신경망은 생물학적 신경계의 작동 원리와 구조에서 영감을 받아 개발된 신경망 모델입니다. 이 모델은 뇌의 뉴런 동작 원리와 시간적 특성을 기반으로 합니다. 뇌의 뉴런은 시간적으로 간격을 두고 전기 신호인 스파이크를 생성하며, 이러한 스파이크는 다른 뉴런으로 정보를 전달하고 처리하는 방식으로 작용합니다.

스파이크 인공 신경망은 이러한 생물학적 신경망의 특성을 모방하여 입력 및 출력 신호를 스파이크 형태로 처리하고 정보를 전달합니다. 이로 인해 스파이크 인공 신경망은 인공 지능의 새로운 차원을 열어주며, 그 중요성은 더욱 부각되고 있습니다.

2-1. 스파이크 인공 신경망의 구성 요소

스파이크 인공 신경망은 뉴런과 시냅스라는 핵심 구성 요소로 이루어져 있습니다. 뉴런은 입력 신호를 수신하고 내부적인 연산을 통해 스파이크라 불리는 전기 신호를 생성합니다. 각 뉴런은 입력에 대한 반응을 시간적으로 연속적인 스파이크 형태로 표현하여 복잡한 패턴을 효과적으로 처리합니다. 이때 스파이크 생성 여부와 시간적 패턴은 뉴런의 활성화 함수에 의해 결정됩니다.

시냅스는 뉴런 간의 연결을 의미하며, 스파이크 신호가 전달되는 경로입니다. 시냅스 가중치는 뉴런 간의 스파이크 전달 강도를 조절하는 역할을 합니다. 뉴런과 뉴런 사이의 시냅스 강도를 조정하여 정보의 흐름과 가중치를 학습을 통해 조절하며, 이것이 스파이크 인공 신경망의 학습 과정입니다. [1]

이러한 뉴런과 시냅스의 조합으로 SNN은 복잡한 신호 처리와 패턴 인식 등 다양한 문제를 수행합니다.

2-1-1. 스파이크 인공 신경망 뉴런 모델

그림 2. 시간에 따른 LIF 모델의 Potential 및 Spike 동작 특성

스파이크 뉴런 모델 중에서도 LIF (Leaky Integrate-and-Fire) 모델은 가장 일반적으로 사용되는 뉴런 모델 중 하나입니다. 이 모델은 그림 2와 같이 생물학적 뉴런의 동작을 간단하게 모방한 것으로, 입력 스파이크(그림 2의 Input Spike)가 뉴런의 막 전위(그림 2의 Potential)를 증가시키며, 일정한 임계값에 도달하면 스파이크를 생성(그림 2의 Output Spike)하고 막 전위를 초기화합니다.

LIF 모델은 다음과 같은 수식으로 나타낼 수 있습니다.

여기서 C는 뉴런의 전기용량(Capacitance), dV/dt는 막전위 V의 시간에 대한 변화율, R은 막 전위의 시간에 따른 감쇄율을 결정하는 막 저항(Membrane Resistance)을 나타내며, Isyn (t)는 시냅스로부터의 입력 전류를 나타냅니다.

LIF 모델에서 스파이크가 생성되는 조건은 막전위 V가 일정한 임계값 Vth에 도달할 때입니다. 이를 다음과 같은 조건으로 표현할 수 있습니다.

if V(t)≥Vth then generate a spike

스파이크가 생성되면 막전위 V는 초기화되고, 스파이크의 생성 타이밍을 조절하는 휴지 기능이 포함됩니다. 이러한 LIF 모델은 시간적 패턴을 모방하고 스파이크 생성을 통해 정보 처리를 수행하는데 효과적인 수학적 모델 중 하나입니다.

2-2. 스파이크 인공 신경망의 다양한 구조

스파이크 인공 신경망은 다양한 구조로 설계되어 다양한 응용 분야에 적용됩니다. 그 중에서도 Spiking Recurrent Neural Network (SRNN)과 Spiking Convolutional Neural Network (SCNN)은 대표적인 구조로, 각각 순차적인 정보 처리와 이미지 처리에 특화되어 있습니다.

2-2-1. 스파이크 순환 신경망 (SRNN, Spiking Recurrent Neural Network)

그림 3. 스파이크 순환 신경망 구조 및 연결 (a) Folded Model, (b) Unfolded Model

스파이크 순환 신경망은 순차적인 정보 처리에 효과적인 구조로, 시계열 데이터와 같은 입력에 적합합니다. 이 구조는 내부적으로 순환 연결을 가지며, 이전 시간 단계의 뉴런 상태를 현재 시간 단계의 입력 처리에 활용합니다. 이렇게 순환 연결을 통해 과거 정보를 유지하면서 입력 데이터를 처리할 수 있습니다. 스파이크 순환 신경망은 시계열 예측, 자연어 처리 및 제어 문제와 같은 도메인에서 유용하게 활용될 수 있습니다.

스파이크 순환 신경망은 Recurrent 모델로 분류되므로, 그림 3(a)와 같이 Folded Model로 나타내거나, 그림 3(b)와 같이 시간 축을 따라 Unfolded Model로 연결 구조를 확인할 수 있습니다. 스파이크 순환 신경망은 공간적으로 Forward connection을 가지며 동시에 시간적으로 Recurrent connection을 갖고 있습니다. 스파이크 순환 신경망의 각 Hidden 유닛은 Potential과 Spike로 구성되며, 각 Potential과 Spike는 다음 시간 단계에 영향을 미치는 구조를 가지고 있습니다. 이러한 구조는 시간적인 비선형성을 부여하며 시간적으로 복잡한 시계열 문제에 대한 우수한 성능을 보입니다. [2], [3]

2-2-2. 스파이크 합성곱 신경망(SCNN, Spiking Convolutional Neural Network)

그림 4. 스파이크 합성곱 신경망 구조

스파이크 합성곱 신경망은 이미지 처리 및 패턴 인식에 특화된 구조입니다. 입력 데이터의 공간적 패턴을 탐지하고 처리하는 데 효과적인 구조입니다. 그림 4와 같이 스파이크 합성곱 신경망은 데이터를 학습할 때, Spike Encoding하여 합성곱 연산을 활용하여 입력 데이터의 지역적 패턴을 추출합니다. 이러한 과정에서 뉴런 간의 연결을 통해 전역적인 의미를 형성합니다.

스파이크 합성곱 신경망은 예시 그림 4와 같이 이미지 분류를 수행할 수 있으며 객체 감지 및 추적, 인식과 같은 컴퓨터 비전 관련 작업에 특히 적합합니다. 또한, 입력 데이터의 공간적 구조를 활용하여 정교한 패턴 분석을 수행할 수 있습니다.

3. 스파이크 인공 신경망 학습 알고리즘

스파이크 기반 학습은 입력 스파이크 패턴과 그에 따른 출력 스파이크 패턴 간의 관계를 학습하여 신경망이 원하는 작업을 수행하도록 조정하는 과정을 의미합니다. 스파이크 인공 신경망에서의 학습은 생물학적 뉴런의 작동 원리와 유사한 원리를 기반으로 하여 주로 두 가지 핵심 요소로 구성됩니다.

첫째, 시냅스의 가중치 조정입니다. 시냅스는 뉴런 간의 연결을 나타내며, 입력 스파이크와 출력 스파이크 사이의 강도를 결정하는 가중치를 조절합니다. 이 가중치 조정은 학습 알고리즘을 통해 이루어지며, 입력 스파이크 패턴이 원하는 출력 스파이크 패턴을 유도할 수 있도록 조절됩니다.

둘째, 시간적 타이밍에 관한 학습입니다. 스파이크 인공 신경망은 스파이크의 발생 시간을 고려하여 정보를 처리하며, 이를 타이밍 정보로 활용합니다. 따라서 학습 알고리즘은 입력 스파이크와 출력 스파이크의 정확한 시간적 관계를 학습하고 이를 통해 패턴을 인식하고 학습합니다.

이러한 스파이크 기반 학습은 스파이크 인공 신경망이 복잡한 신호 처리와 패턴 인식 작업을 수행하는 데 효과적으로 활용됩니다.

3-1. 스파이크 타이밍 의존성 학습 (STDP, Spike-Timing Dependent Plasticity)

스파이크 타이밍 의존성 학습은 스파이크 인공 신경망에서 가장 널리 사용되는 학습 알고리즘 중 하나입니다.[4], [5] 이 알고리즘은 두 개의 뉴런 사이의 스파이크 발생 시간 차에 따라 시냅스 강도를 조절하여 학습을 수행합니다. 스파이크 타이밍 의존성 학습은 뉴런 간의 연결 강도를 조절함으로써 스파이크의 동시성 및 순차성을 학습하는 데에 활용됩니다.

그림 5. 비지도 스파이크 타이밍 의존성 학습 (a) 뉴런 연결 구조, (b) 시냅스 강도의 상대적 변화

뉴런 A가 뉴런 B를 활성화시킨다면, A가 B의 활성화에 어떤 정도의 영향을 미쳤는지 감지하고, 만약 A가 B의 활성화에 긍정적인 영향을 미쳤다면, A에서 B로 이어지는 시냅스의 가중치를 증가시킵니다. 그러나 B가 A를 활성화한다면, B의 활성화가 A에게 어떤 영향을 미쳤는지를 감지한 후, B에서 A로 이어지는 시냅스의 가중치를 증가시킵니다. 이는 그림 5(b)와 같이 작용합니다.

이러한 규칙을 수식으로 나타내면 다음과 같습니다. 시냅스 가중치를 W라고 할 때, 뉴런 A가 뉴런 B를 활성화시킨 경우 (A→B), 가중치 증가는 다음과 같이 나타낼 수 있습니다.

여기서 Apre는 A의 활성화의 강도, τpre는 A의 활성화 지속 시간, Δt는 B의 스파이크가 일어난 시간과 A의 스파이크가 일어난 시간의 차이, 그리고 τ+는 시냅스 강도 조정에 사용되는 시간 상수입니다.

반대로 뉴런 B가 뉴런 A를 활성화시킨 경우 (B→A), 가중치 감소는 다음과 같이 나타낼 수 있습니다.

여기서 Apost는 B의 활성화의 강도, τpost는 B의 활성화 지속 시간, τ_-는 시냅스 강도 감소에 사용되는 시간 상수입니다.

스파이크 타이밍 의존성 학습은 스파이크의 타이밍에 따라 가중치를 조절하여 네트워크가 입력 스파이크 패턴을 학습하도록 합니다.

3-2. 역전파 학습 (BP, Backpropagation)

그림 6. 인공 신경망, 스파이크 인공 신경망에서의 역전파 학습 알고리즘

스파이크 인공 신경망과 인공 신경망 간의 큰 차이 중 하나는 입력과 출력의 처리 방식입니다. 인공 신경망에서는 연속적인 활성화 함수를 사용하여 연속적인 출력값을 생성하며, 이러한 연속적인 값을 다루기 위해 그림 6과 같이 그레디언트를 활용한 역전파 알고리즘을 사용하여 네트워크를 학습시킵니다. 그러나 스파이크 인공 신경망은 이산적인 스파이크 신호를 다루기 때문에 그레디언트 계산에 어려움이 있습니다.

그림 7. 인공 신경망 및 스파이크 인공 신경망의 활성화 함수

이러한 문제를 해결하기 위해 Surrogate Gradient를 활용한 역전파 알고리즘이 제안되었습니다. [6] 그림 7에서 볼 수 있듯이, 인공 신경망에서 사용하는 활성화 함수인 Sigmoid, tanh는 미분 가능성을 갖고 있지만 스파이크 인공 신경망에서 사용하는 활성화 함수인 Step function의 경우 미분 가능하지 않습니다.

그림 8. 스파이크 인공 신경망의 역전파 알고리즘을 위한 Surrogate Gradient

그림 8과 같이, 스파이크 신호의 불연속성을 극복하기 위해 다양한 Surrogate gradient를 활용하여 스파이크 신호와 그레디언트 사이의 관계를 설정합니다. Surrogate gradient는 연속적인 함수로 대체되는 함수로서, 이를 통해 연속적인 그레디언트 계산이 가능해집니다. Surrogate gradient를 이용한 역전파 알고리즘은 스파이크 인공 신경망의 학습을 가능하게 하며, 기존의 연속적인 역전파 알고리즘과 유사한 방식으로 신경망을 업데이트합니다.

Surrogate gradient를 사용한 역전파 알고리즘은 여전히 활발한 연구 주제 중 하나입니다. 그레디언트 근사치의 정확성과 수렴 속도 등의 측면에서 여전히 도전과제가 남아 있습니다. 따라서 스파이크 인공 신경망 학습에 이 방법을 적용하는 경우 신중한 접근과 실험을 통한 검증이 필요합니다.

4. 향후 발전 방향

스파이크 인공 신경망은 지속적인 연구와 발전을 거듭하고 있는 분야입니다. 특히, 스파이크 인공 신경망 학습 알고리즘의 연구와 개발은 스파이크 인공 신경망의 실용성을 확대하고 다양한 응용 분야에서의 활용 가능성을 확장하는 데 중요한 역할을 할 것으로 예상됩니다.

4-1. 스파이크 인공 신경망 학습 알고리즘의 연구와 개발

스파이크 인공 신경망 학습 알고리즘에 대한 연구는 현재도 끊임없이 진행 중입니다. 새로운 학습 규칙과 알고리즘, surrogate gradient를 활용한 방법 및 실시간 학습 등 다양한 연구가 개발되고 있습니다. [7], [8] 또한, 스파이크 신호를 고려하여 저전력으로 구동할 수 있으면서도 빠르고 효과적인 학습을 달성하기 위한 연구가 진행되고 있습니다. 이러한 연구들은 스파이크 신호 처리와 학습 메커니즘을 더욱 정교하게 다룰 수 있는 방향으로 나아갈 것으로 전망됩니다.

4-2. 응용 분야 확장 가능성

스파이크 인공 신경망의 응용 분야는 계속해서 확장될 것으로 전망됩니다. 현재, 스파이크 인공 신경망은 신경과학 연구를 통한 뇌 기능 모델링과 신경 질환 연구와 같은 다양한 분야에서 활용되고 있습니다. 또한, 스파이크 신호의 이산적인 특성은 실시간 데이터 처리 및 이벤트 기반 처리와 같은 분야에서도 효과적으로 활용될 수 있습니다.

스파이크 인공 신경망의 응용 분야 다변화 및 확장은 하드웨어 기술의 발전과도 밀접한 관련이 있습니다. 신경 계산 하드웨어의 발전은 스파이크 인공 신경망을 더욱 효율적으로 실행하고 실시간 처리를 가능케 하며, 따라서 스파이크 인공 신경망의 응용 분야가 다양화되고 확장되는 데 도움이 될 것으로 기대됩니다.

5. 결론

스파이크 인공 신경망은 생물학적 뉴런의 작동 원리를 모방한 혁신적인 신경망 모델로, 스파이크 신호를 활용하여 정보 처리와 학습을 수행합니다. 이러한 스파이크 인공 신경망은 뇌의 복잡한 동작 원리와 신호 전달 방식을 모방하면서도 컴퓨터 과학과 인공 지능 분야에서 혁신적인 접근을 제시하고 있습니다.

스파이크 인공 신경망을 이해하고, 뉴런 동작을 모방한 LIF 모델과 스파이크 순환 신경망, 스파이크 합성곱 신경망 등을 살펴봄으로써 SNN의 다양한 구조와 장점을 파악할 수 있었습니다. 이러한 구조들은 각각의 특성과 장점을 가지고 있어 다양한 문제에 특화된 활용 가능성을 제시하고 있습니다.

스파이크 인공 신경망 학습 알고리즘인 스파이크 타이밍 의존성 학습과 surrogate gradient를 통한 역전파 학습을 비롯하여 다양한 학습 알고리즘이 지속적으로 연구되고 있으며, 이를 통해 스파이크 인공 신경망의 학습 가능성과 효율성을 높이고 있습니다. 이러한 학습 알고리즘은 네트워크의 가중치 조정과 정보 처리에 중요한 역할을 하며, 더욱 정교한 학습 메커니즘의 개발을 향상시킬 것으로 기대됩니다.

향후에는 스파이크 인공 신경망 학습 알고리즘의 연구와 개발을 통해 더욱 정교한 학습 메커니즘을 개발하고, 스파이크 인공 신경망의 응용 분야를 더욱 확장시킬 것으로 기대됩니다. 신경과학 연구부터 실시간 데이터 처리 및 이벤트 기반 처리와 같이 다양한 분야에서의 활용은 스파이크 인공 신경망의 중요성을 더욱 부각시키고 있으며, 이러한 발전은 하드웨어 기술과의 연계를 통해 더욱 효율적인 실행과 응용 확장을 이끌 것입니다.

마지막으로, 스파이크 인공 신경망은 다양한 기술과 과학 분야의 융합을 통해 미래의 혁신적인 솔루션을 제시할 것입니다. 신경과학과 컴퓨터 과학, 인공 지능 분야와의 긴밀한 협력을 통해 스파이크 인공 신경망의 역량은 더욱 확대될 것으로 기대하며, 이러한 발전은 다음 세대의 지능적인 기술과 시스템에 기여할 것입니다.

6. 참고 문헌

[1] Eshraghian, Jason K., et al. "Training spiking neural networks using lessons from deep learning." arXiv preprint arXiv:2109.12894 (2021).

[2] Yin, Bojian, Federico Corradi, and Sander M. Boht?. "Accurate and efficient time-domain classification with adaptive spiking recurrent neural networks." Nature Machine Intelligence 3.10 (2021): 905-913.

[3] Traub, Manuel, et al. "Dynamic action inference with recurrent spiking neural networks." International Conference on Artificial Neural Networks. Cham: Springer International Publishing, 2021.

[4] Caporale, Natalia, and Yang Dan. "Spike timing?dependent plasticity: a Hebbian learning rule." Annu. Rev. Neurosci. 31 (2008): 25-46.

[5] Tavanaei, Amirhossein, and Anthony Maida. "BP-STDP: Approximating backpropagation using spike timing dependent plasticity." Neurocomputing 330 (2019): 39-47.

[6] Neftci, Emre O., Hesham Mostafa, and Friedemann Zenke. "Surrogate gradient learning in spiking neural networks: Bringing the power of gradient-based optimization to spiking neural networks." IEEE Signal Processing Magazine 36.6 (2019): 51-63.

[7] Bellec, Guillaume, et al. "A solution to the learning dilemma for recurrent networks of spiking neurons." Nature communications 11.1 (2020): 3625.

[8] Bohnstingl, Thomas, et al. "Online spatio-temporal learning in deep neural networks." IEEE Transactions on Neural Networks and Learning Systems (2022).

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>

본 기사의 전문은 PDF문서로 제공합니다.

(로그인필요)

다운로드한 PDF문서를 웹사이트, 카페, 블로그등을 통해 재배포하는 것을 금합니다. (비상업적 용도 포함)

다운로드한 PDF문서를 웹사이트, 카페, 블로그등을 통해 재배포하는 것을 금합니다. (비상업적 용도 포함)

100자평 쓰기