차원용 아스팩미래기술경영연구소 소장, 국가과학기술심의회 전문의원

※ 본 보고서는 창조경제연구회가 2016년 3월 29일 개최한 ‘인공지능과 제4차 산업혁명’이라는 포럼과 보고서 및 2016년 4월 6일자의 ‘DIGIEO’에 등재한 ‘인공지능의 오해와 진실’의 내용을 약간 업데이트하여 오픈하는 것입니다.

www.facebook.com/kcern.org,

www.digieco.co.kr/KTFront/report/report_issue_trend_view.action?board_id=issue_trend&board_seq=10845&gubun=aa

인공지능 때문에 전세계가 난리이다. 최근 개최된 2016년 세계경제포럼이 발표한 ‘일자리의 미래(The Future of Jobs)’라는 보고서에서 인공지능·로봇기술·생명과학 등이 이끄는 4차 산업혁명으로 인해, 앞으로 5년 안에 710만개의 기존 직업들이 사라지고, 기존에 없던 새 일자리가 210만개 만들어진다는 것이다. 그 결과 총 500만개의 일자리가 사라진다는 것이다. 과연 그럴까? 또한 미국의 국방성은 2017년 예산으로 인공지능이 탑재된 무기를 개발하기 위해 120억~150억 달러를 의회에 요청했다는 보도이다.

이러한 관점에서 사진 속의 감정과 이름을 읽는 지금의 인공지능 현실, 구글의 인공지능 자율주행컴퓨터의 현실, 인간의 신경세포와 비신경세포의 지금까지 밝혀진 현실, 전세계의 디지털 데이터는 얼마, IBM의 왓슨(Watson)의 현실, 알파고가 이세돌을 이기다 등의 인공지능 현실을 살펴보고, 엘론 머스크가 이끄는 OpenAI의 전력과 방향과 미국의 FLI가 주도하는 긍정적인 AI 발전을 위한 ELSI 사전 연구를 살펴보면서 각각의 인사이트와 시사점을 주고자 한다.

1. 제4차 산업혁명이 500만개의 일자리를 빼앗는다고?

스위스 다보스에서 개최된 2016년 세계경제포럼(WEF)의 주제는 ‘제4차 산업혁명’이고, 이 혁명을 주도하는 인공지능·로봇기술·생명과학·3DP·드론 등이 궁극적으로 인간의 일자리를 빼앗는다는 것이다. 세계경제포럼이 발표한 ‘일자리의 미래(The Future of Jobs)’(WEF, 18 Jan 2016)라는 보고서(www.weforum.org/reports/the-future-of-jobs)에서 4차 산업혁명으로 인해 상당수 기존 직업이 사라지고, 기존에 없던 새 일자리가 만들어진다는 것이다.

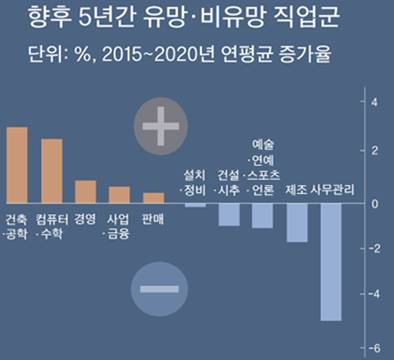

〈그림1〉 향후 5년간 유망·비유망 직업군. 출처: 〈중앙일보〉, '전 세계 7세 아이들 65%는 지금 없는 직업 가질 것'(news.joins.com/article/19441065)(20 Jan 2016)

한국이 포함되지 않은 조사에서, 각국의 인사 담당 임원들은 4차 산업혁명으로 인해 일반 사무직을 중심으로 제조·예술·미디어 분야 등에서 710만 개의 일자리가 사라질 것이라고 예상했으며, 반면 컴퓨터·수학·건축 관련 일자리는 200만 개가 창출될 것으로 예상해, 결과적으로 500만 개 일자리가 2020년까지 없어진다는 것이다1). 하지만 이러한 신기술들이 정말로 2020년까지 500만 개의 일자리를 대체할 수 있을까? 너무 부정적인 시나리오를 바탕으로 한 것은 아닐까? 인공지능·인공로봇 들과 함께 어울리는 그러한 긍정적인 동반자적인 미래사회는 정말 아니 오는 것일까?

1) FT, 'Robots, automation, and AI will replace 5 m human jobs by 2020'(20 Jan 2016)

www.ft.lk/article/519947/Robots--automation--and-AI-will-replace-5-m-human-jobs-by-2020

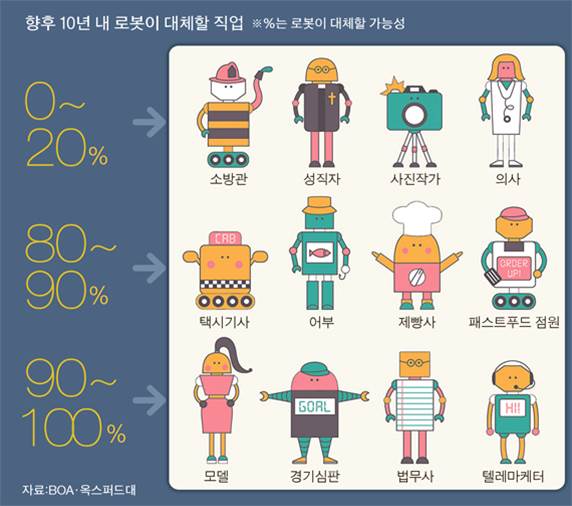

〈그림2〉향후 10년 내 로봇이 대체할 직업. 출처: 중앙일보(20 Jan 2016)

2. 미국 국방성의 인공지능이 탑재된 무기 개발

미국의 국방성은 2017년 예산으로 인공지능이 탑재된 무기(AI Weapons)를 개발하기 위해 120억~150억 달러를 의회에 요청했다는 외신 보도이다(Reuters, 14 Dec 2015; Future of Life, 15 Dec 2015)2).

2) Reuters, 'Pentagon eyes $12-15 billion for early work on new technologies'(14 Dec 2015)

www.reuters.com/article/us-usa-military-technologies-idUSKBN0TX1UR20151214

Future of Life, 'Pentagon Seeks $12 -$15 Billion for AI Weapons Research'(15 Dec 2015)

futureoflife.org/2015/12/15/pentagon-seeks-12-15-billion-for-ai-weapons-research

미국 국방성은 중국과 러시아와의 군사 경쟁력에서 우위를 확실히 하기 위해 딥러닝 베이스의 전쟁 게임과 딥러닝이 탑재된 자율무기(autonomous weapons) 등 전략적 자산 확보에 나선 것으로 보인다. 또한 국방성은 중국과 러시아도 인공지능이 탑재된 무기를 개발하는 것으로 판단하고 있다는 것이다. “저는 중국과 러시아가 검은 커튼 뒤에서 무엇을 하는지 알고 싶습니다(I want our competitors to wonder what’s behind the black curtain)”라고 국방성 대변인인 로버트 워크(Robert Work)가 밝혔다. 만약 AI 무기가 개발된다면 전쟁 억제력(war deterrence)이 강화될 것으로 군사전문가들과 업계들은 믿고 있다.

국방성은 이들 AI 무기가 전쟁터에서 인간과 한 팀이 되어 인간과 기계가 협력하는 방향에 초점을 맞출 것이라고 국방성은 밝혔다. 인공지능이 탑재된 새로운 기술들로는 인공지능 네트워킹 시스템으로 전쟁터에서 상관의 다음 지시를 기다리는 것이 아니라 이전에는 몰랐던 적군의 방어망을 분석하여 위치를 정확히 찾아내서 독자적으로 미사일을 쏘도록 하는 것이다.

이외에 병사들이 입는 전자 옷의 전투복, 폭탄을 몸무게의 10배 이상을 들 수 있고 날아 갈수 있는 외골격 같은 정장(Exoskeleton suit), 자율 무인기와 드론, 자율 드론과 무인기 등을 급파할 수 있는 자율 모선(mother ships) 등이다. 이에 대해 무기 제조업체들인 록히드 마틴(Lockheed Martin), 보잉(Boeing), 노쓰랍 구루만(Northrop Grumman) 등은 비상한 관심을 보이고 있다는 보도이다.

하지만 국방성 내부에서는 이에 대해 회의론자들도 많다는 것이다. 그러한 인공지능 네트워크 시스템이 정말로 완벽하게 적군을 찾아내고 아군을 보호할 수 있느냐는 것이다. 다시 말해 지금의 인공지능이 거의 완벽한 수준이냐라는 것이다.

그럼에도 불구하고 작금의 인공지능 수준이 이미지 분석이나 게임에 국한되고 있다는 것을 감안하면 역시 미국이라는 생각이 든다. 미국을 보면 신기술이 나오면 제일먼저 국방이나 우주에 적용하고, 성공하면 민영화시키는 전략을 구사해 왔기 때문이다. 그것도 무지막지한 자금을 투입해 먼저 시도하여 인공지능 분야를 선도하겠다는 전략으로 보아야 할 것이다.

3. 인공지능의 현실

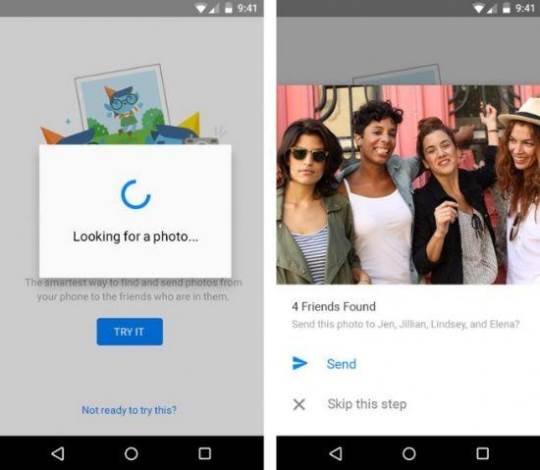

3-1. 사진 속의 감정과 이름을 읽어?

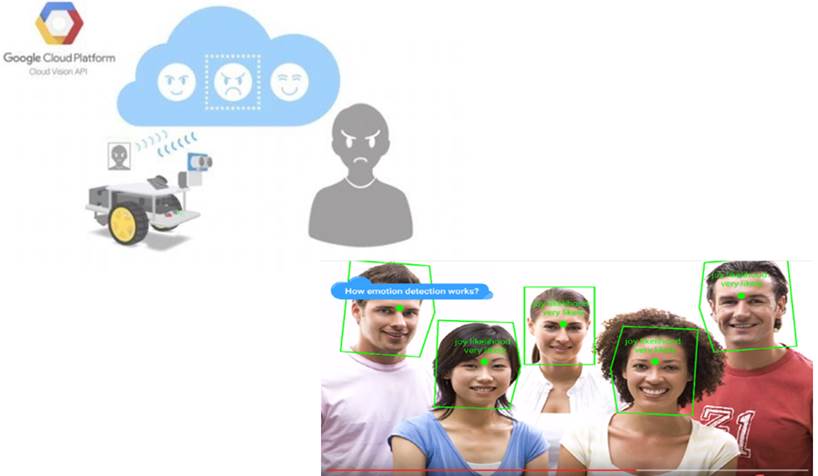

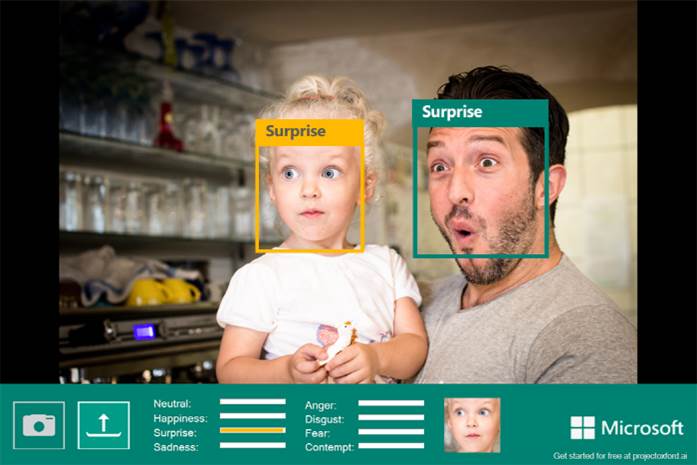

현실을 보자. 작년 말에서 올 초까지 구글, 마이크로소프트, 페이스북은 인공지능·기계학습·딥 러닝의 오픈 소스를 공개하고 그간의 성과를 발표했는데, 사진 속에 찍힌 사람들의 이름을 찾아내고, 사진 속의 얼굴을 인식해 얼굴 표정의 분노, 행복, 무관심, 슬픔, 놀라움 등 8가지 감정들이 수치화돼 표시되는 수준이다. 구글의 클라우드 비전 API의 로봇도 사람의 얼굴을 보고 감정을 알아내는 정도이다.

〈그림3〉사람 얼굴의 감정을 알아내는 구글의 클라우드 비전 API. 출처: Google Youtube, 'What is Cloud Vision API?'(www.youtube.com/watch?v=eve8DkkVdhI)(02 Dec 2015)

〈그림4〉사람 얼굴의 감정을 알아내는 MS의 프로젝트 옥스포드의 감정 API. 출처: MS - Project Oxford Emotion API(www.projectoxford.ai/emotion)

〈그림5〉사진 속의 친구 이름을 알아내는 페이스북의 인공지능. 출처: IdownLoadBlog, 'Facebook’s facial recognition coming to Messenger'(www.idownloadblog.com/2015/11/09/facebook-messenger-facial-recognition)(9 Nov 2015)

사진 속의 얼굴인식률은 95% 수준으로 이름을 알아내고 감정을 알아내는 것이 우리와 무슨 상관이 있으며 어떤 새로운 비즈니스를 창출하게 해줄 것인가라는 것이다. 구글의 나우, 애플의 시리, 아마존의 알렉사 등의 자연언어인식 또한 92~95%의 인식률이라고 주장하지만, 사용하는데 시간이 걸리고 때론 알아듣지를 못해 다수가 사용하지 않는다. 이는 아직 5년안에 새로운 비즈니스를 창출할 단계는 아니라는 것을 의미하는 것이다.

3-2. 구글의 인공지능 자율주행컴퓨터의 현실

또 다른 예를 보자. 구글은 2015년 5월부터 매달 자사의 셀프 드라이빙 카(Self-Driving Car) 프로젝트와 자율주행테스트 결과를 공개하고 있는데(Google Self-Driving Car Project - Monthly reports(31 Jan 2016)), 2016년 1월의 자율주행테스트 결과를 2016년 1월 31일에 공개한 자료에 따르면 구글은 인공지능인 자율주행컴퓨터시스템(Autonomous Driving Computer System)이 탑재된 반-자율차(Semi-autonomous car)로 2009년에 캘리포니아에서 테스트(Google Self-Driving Car Project, google.com/selfdrivingcar/where)를 시작한 이래로, 총 주행테스트 거리는 2,408,597 마일(385만km)로, 이중 자율모드(Autonomous mode)로 주행한 거리가 1,419,672마일(227만km, 약 60%)이고, 매뉴얼모드(Manual mode)로 주행한 거리가 988,925마일(158만km, 약 40%)이다.

자율모드 주행이 60%라는 것은 무엇을 의미하는 것일까? 그만큼 도로 인프라가 정비가 안되었다는 것을 의미하고, 기존 도로의 선행 상세지도(Detailed Prior Map)가 없어 이 작업을 선행해야 하기 때문에 매뉴얼모드 주행이 40%나 된다는 것을 시사하는 것이지만, 이것은 또한 아직 인공지능이 완벽하지 못하다는 것으로 상용화에 그만큼 시간이 많이 걸린다는 것을 의미하는 것이다.

〈그림6〉 반-자율차. 구글이 2012년에 개조한(modified) 렉서스 RX450h SUV. 출처: Google Self-Driving Car Project(google.com/selfdrivingcar/where)

다음엔 더 쇼킹한 뉴스이다. 구글은 도로에서 자율주행테스트를 할뿐만 아니라, 반-자율차가 도로로 나가기 전에 기계학습 알고리즘(Machine learning algorithm) 베이스의 버추얼 환경을 구축한 랩에서 드라이빙 훈련을 시키고 있다는 사실이다. 지난 7년간 도로주행에 나선 반-자율차들이 수집한 무지막지한 빅 데이터들을 이용해, 아직 도로주행에 나서지 않은 반-자율차에 탑재된 자율주행컴퓨터시스템에 입력해 드라이빙을 추론하고 상기시키는 것이다.

컴퓨터 시뮬레이터는 드라이빙 패턴의 수천 가지 변형 모델을 만들어 낸다. 그러면 버추얼로 수백만 마일을 곡예 주행할 수 있다. 이러한 방식으로 구글의 반-자율차들은 하루에 300만 마일(480만km)의 버추얼 도로를 주행하면서 학습하는 것이다(Cnet, 16 Feb 2016)3). 그리고 기계학습 알고리즘의 소프트웨어를 업데이트 시키는 것이다. 그럼에도 불구하고 실제 도로주행에선 아직 인간의 눈과 귀와 손과 발과 두뇌를 따라오지 못하는 것이다.

3) Cnet, 'Computer simulation creates "thousands of variations" of driving patterns, enabling Google's engineers to quickly test tweaks across millions of virtual miles'(16 Feb 2016).

http://www.cnet.com/news/how-googles-self-driving-cars-drive-3-million-miles-a-day

Google Self-Driving Car Project, 'Monthly reports'(31 Jan 2016)

〈그림7〉완전 자율기능의 100% 자율차. 구글이 2014년 5월에 컨셉화하고 12월에 선보인 새로운 프로토타이프(Prototype)의 자율차. 출처: Google Self-Driving Car Project(google.com/selfdrivingcar/where)

그러나 운전자가 반드시 있어야 한다는 규정 때문에, 이 완전 기능의 자율차 프로토타이프에 다시 운전대-가속 페달-브레이크 페달을 붙인 것이다. 단, 언젠가는 제거할 수 있는(Removable) 탈-부착 형태로 변형했다. 그리고 변형된 반자율차의 프로토타이프를 2015년 5월에 공개한 후(MotorTrend, 15 May 2016)4), 2015년 9월부터 운전자 2인과 함께 도로주행에 투입하고 있다(Popsci, 1 Sep 2015)5).

4) Google Self-Driving Car Project, 'Our prototype vehicles will leave the test track and hit the familiar roads of Mountain View, California, with our safety drivers aboard'(15 May 2015)

plus.google.com/+SelfDrivingCar/posts/VG8ZtPPd3Xr

MotorTrend, 'Google Self-Driving Cars Begin Tests on City Roads This Summer'(15 May 2015)

www.motortrend.ca/en/news/1505-google-self-driving-cars-begin-tests-on-city-roads-this-summer

5) Popsci, 'GOOGLE’S SELF-DRIVING CAR PROTOTYPES ARE COMING TO PUBLIC ROADS IN AUSTIN'(01 Sep 2015)

www.popsci.com/google-self-driving-car-driverless-vehicle

또한 구글이 미국 캘리포니아주 자동차국(DMV)에 제출한 32페이지 분량의 '자율주행 운행 중 자율주행모드해제 보고서(Self-Driving Car Testing Report on Disengagements of Autonomous Mode)'6)에서 구글은, 캘리포니아 자동국으로부터 허가를 받은 2014년 9월 24일부터 2015년 11월 30일까지, 캘리포니아 마운틴 뷰의 교외(suburban)에서 총 524,003마일(84만km)의 주행테스트를 했으며, 이중 자율모드 주행이 424,331마일(68만km)이고 매뉴얼모드 주행이 99,672마일(16만km)이라고 밝혔다. 결국 자율모드 주행이 60%에서 80%로 향상되었지만 20%가 매뉴얼모드 주행으로 구글이 희망하는 완전 자율기능의 100%의 자율차는 아직 멀었다는 것을 의미하는 것이다.

6) California DMV, 'Autonomous Vehicle Disengagement Reports'(13 Jan 2016)

www.dmv.ca.gov/portal/dmv/detail/vr/autonomous/disengagement_report

구글은 보고서에서 14개월간 자율주행차 49대로 약 68만 km 거리의 자율주행 시험을 하면서 총 341회의 '자율주행모드 해제' 사례를 겪었다고 보고했다. 그 중 하드웨어 기능이 잘못되어 해제된(disengage for hardware discrepancy) 경우는 39건이라고 보고했는데, 이는 센싱 시스템, 브레이킹 제어, 컴퓨팅시스템의 하드웨어 등이 실제 기대만큼 수행을 못한 경우이다. 이것은 실제 구글의 반-자율차 문제로, 11.4%나 된다는 것이다. 아직 한참 가야 한다는 의미이다. 또한 보고서에서 반-자율차의 원하지 않은 운행(disengage for unwanted maneuver of the vehicle)의 경우는 55건이라고 보고했는데, 이는 주차된 차량에 너무 가까이 가는 등의 바람직하지 않은 방법으로 반-자율차가 움직였다는 것을 의미하는 것으로, 이것도 실제 반자율차의 문제로 16%나 된다. 아직 한참 가야 한다는 의미이다.

3-3. 인간의 신경세포와 비신경세포의 현실

자 이번에는 그간 밝혀진 인간의 뇌의 내용을 보자. 뇌에는 1,000억 개(10의 11승, 100기가)의 뉴런이 있고, 하나의 뉴런은 10,000개(10의 4승)의 시냅스와 연결되어 있으니, 10의 11승 x 10의 4승 = 10의 15승(1,000조, 1페타)의 시냅스가 있다. 그런데 이게 다가 아니라는 점이다.

우리 뇌에는 비신경세포도 있는데, 그리스어로 아교라는 뜻의 신경교(neuroglia) 세포 또는 성상세포(별세포, astrocytes)는 두뇌로의 혈액의 이동과 잠자는 동안 뇌의 폐수 물을 처리하는데, 그 수는 1,000억개의 뉴런 수와 비슷하다. 그러면 우리 뇌에는 10의 15승 x 10의 11승 = 10의 26승(100요타)개가 연결되어 있다. 그런데 이게 다가 아니라는 점이다. 뉴런을 연결하고 스스로도 상호 연결하는 연합뉴런(게재, 중개, Interneuron)이 있다. 고등 동물의 신경계일수록 이 연합 뉴런의 수와 연결 가지 수가 많아서, 보다 높은 복잡한 사고작용을 하는데, 인간의 뉴런 하나 당 연합뉴런은 1,000(10의 3승)개가 연결된 것으로 알려져 있다. 이것은 뇌에 있는 연합뉴런이다.

그런데, 미국 솔트 연구소(The Salk Institute)를 중심으로 하버드 의대(Harvard Medical School), 유씨샌디에고(University of California, San Diego), 그리고 중국 상하이의 푸단대(Fudan University)의 과학자들이 가려움(Itching)의 메커니즘이 밝혀냈는데(Bourane and Goulding et al., Science, 30 Oct 2015)7), 척추(spinal cord)의 개재뉴런(interneuron)이 발현하는 NPY(neuropeptide Y) 단백질이 가려움을 담당한다는 것이다. 근질근질할 때 긁는 것은 어디까지나 피부의 털의 문제(To scratch an itch is a hairy problem)라는 것이다. 이것은 무엇을 의미하는가 하면 척추에는 두 개의 터치 감각 신경회로가 있다는 것으로, 하나는 털이 있는 피부를 위한 것이고 다른 하나는 털이 없는 손바닥 같은 피부를 위한 것이라는 것이다(Science Daily, 29 Oct 2015)8).

7) Bourane and Goulding et al.,'Gate control of mechanical itch by a subpopulation of spinal cord interneurons', Science, Vol. 350, no. 6260, pp. 550-554(30 Oct 2015)

www.sciencemag.org/content/350/6260/550

8) Science Daily, 'To scratch an itch is a hairy problem'(29 Oct 2015)

www.sciencedaily.com/releases/2015/10/151029150255.htm

이와 같이 우리 몸을 움직이고 생각하게 하고 사고하게 하는 세포들이 셀 수 없이 많다는 것이다.과학자들은 신경세포와 비신경세포가 대략 3대 7의 비율로 추정하고 있어, 뇌를 완전히 밝히기에는 아직 갈 길이 멀다는 뜻이다.

3-4. 전세계의 디지털 데이터는 얼마?

2015년 10월말까지 전세계의 디지털 데이터를 다 합치면 얼마나 될까? 과학잡지 사이언스 데일리는 영국 세퍼필드대(University of Sheffield)가 개발한 소리(Sound)에 저장하는 소리 디스크(Dean & Hayward et al., Applied Physics Letters, 08 Oct 2015)9)를 소개하면서 전세계의 데이터는 2.7 제타(10의 21승)라고 보도했다(Science Daily, 3 Nov 2015)10). 이것은 전세계의 빅 데이터라고 볼 수 있을 것이다. 이 빅 데이터를 어떻게 마이닝하고 패턴을 찾아 분류하고 학습할 것인가가 중요한 것이다. 그래서 인공지능-기계학습(ML)-딥러닝(DL)이 중요한 것인데, 이런 관점에서 이제 시작이라는 의미이다. 아직 갈 길이 멀다는 것이다.

9) Dean & Hayward et al., 'A sound idea: Manipulating domain walls in magnetic nanowires using surface acoustic waves', Applied Physics Letters, Vol. 107, No. 14, 142405, Published online(08 Oct 2015)

scitation.aip.org/content/aip/journal/apl/107/14/10.1063/1.4932057

10) Science Daily, 'The solution to faster computing? Sing to your data. Sound offers new method of moving data in racetrack memory'(3 Nov 2015)

www.sciencedaily.com/releases/2015/11/151103064603.htm

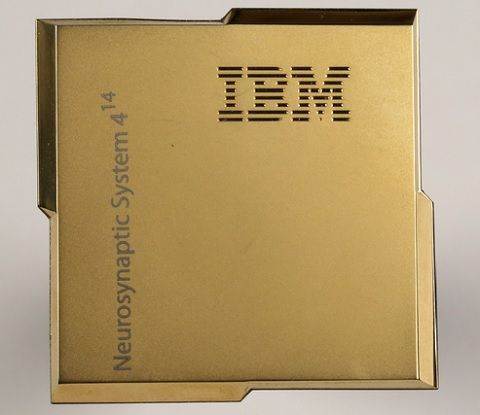

3-5. 왓슨(Watson)의 현실

이번에는 인간의 뉴런과 시냅스 시스템(Neurosynaptic System)을 모방하는 IBM의 최첨단 컴퓨터인 ‘왓슨(Watson)’에 내장된 최첨단 칩(Chip)인 트루노스(TrueNotth)를 보자. 2011년부터 개발하기 시작하여 2015년 9월에 발표한 업데이트 내용을 보면, 인간 뉴런 1,000억개 중 4,800만개가 들어가 4,800만 나누기 1,000억 하면 0.00048%, 인간 1,000조개의 시냅스 중 123억개가 들어가 123억 나누기 1,000조 하면 0.000012%로 아직 설치류 수준으로 인간을 따라 오려면 아직 한참 가야 한다는 뜻이다(I-Programmer, 30 Sep 2015; Popsci, 11 Dec 2015)11).

11) I-Programmer, 'IBM's TrueNorth Rat Brain'(30 Sep 2015)

http://www.i-programmer.info/news/105-artificial-intelligence/9027-ibms-truenorth-rat-brain.html

Popsci, 'FACEBOOK OPEN-SOURCES THE COMPUTERS BEHIND ITS ARTIFICIAL INTELLIGENCE'(11 Dec 2015)

www.popsci.com/facebook-open-source-hardware-behind-artificial-intelligence

또 한가지가 되어야 한다. 우리 인간의 뉴런은 어떻게 연결하여 불을 지피우냐하면(Firing) 때론 나선형(Convolutional)으로, 때론 순환형(Recurrent)으로, 때론 선형형(Linear)으로 때론 비선형(Non-linear)으로 때론 병렬형(Parallel)으로 연결한다는 것이다. 그래서 나온 기계학습과 딥 러닝의 알고리즘들이 다 이런 것들이다.

그러나 인공지능은 한가지 사실을 따라오지 못하고 있다는 것이다. 우리 두뇌의 뉴런들은 불을 지피울 때 고장 난 뉴런이 있으면 점핑(Jumping) 한다는 사실이다. 다시 말해 고장난 뉴런을 건너 뛰어 우회한다는 것이다. 하나를 점프할 수도 있고 두 개를 점프할 수도 있고 10개 100개를 점프할 수 도 있다. 그러나 인간의 두뇌를 모방하는 인공지능칩은 어떤 방식이 되었든 점프할 수가 없다는 것이다. 아직까지는 말이다.

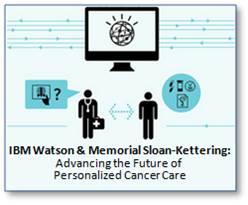

물론 의학의 관점에서 과학적인 증거(Evidence)인 빅 데이터 베이스의 인공지능은 인간보다 나을 수 있다. 세계적인 암센터인 미국 뉴욕의 메모리얼슬론 케터링 암 센터(Memorial Sloan-Kettering Cancer Center)에서는 IBM의 AI 왓슨(Watson)이 전문의와 함께 암·백혈병을 진단한다(Modern Health Talk, 19 Jan 2013; Youtube via IBM Social Media, 21 Mar 2012)12). 미국종양학회(www.asco.org)에 따르면 왓슨의 각종 유방암(BC) 진단 정확도는 91~100%이다(ASCO, 2015)13). 전문의의 초기 오진비율(20~44%)보다 높은 정확도를 나타낸다. 왓슨은 의료진이 각종 임상정보를 입력하면 환자의 상태와 성공 확률이 높은 치료법 등에 대해서도 조언해준다. 왓슨의 역할이 커지면서 이 암센터는 ‘왓슨 종양내과(WFO, Watson for Oncology)’라는 부서까지 만들었다.

12) Modern Health Talk, 'High Tech Advancing Future of Personalized Cancer Care. Memorial Sloan-Kettering Cancer Center, IBM to Collaborate in Applying Watson Technology to Help Oncologists. IBM Watson combined with MSKCC’s clinical knowledge will help physicians access and integrate latest science and knowledge'(19 Jan 2013)

www.mhealthtalk.com/high-tech-advancing-future-of-personalized-cancer-care

Youtube via IBM Social Media, 'Memorial Sloan-Kettering and IBM Watson to Advance Cancer Care.mov'(21 Mar 2012)

http://Www.youtube.com/watch?v=8DBqLTdPolI

13) ASCO, 'Integration of multi-modality treatment planning for early stage breast cancer (BC) into Watson for Oncology, a Decision Support System: Seeing the forest and the trees'(J Clin Oncol 33, 2015).

meetinglibrary.asco.org/content/150846-156

3-6. 알파고가 이세돌을 이겨?

구글이 2014년에 인수한 영국의 딥마인드(DeepMind)가 개발한 알파고(AlphaGo)가 세상의 화제이다. 알파고의 소재지는 영국이다. 한쪽은 이세돌 9단이고, 반대쪽은 인공지능 바둑 프로그램인 알파고가, 미국에 있는 구글의 클라우드를 통해 대국장의 디스플레이에 착수를 놓아 보여주면, 대국장의 대리인인, 알파고 개발팀의 일원인 대만계 아자 황(Aja Huang, 아마 6단)이 대신해 착수를 놓는 방식이다. 결과는 4대 1로 알파고가 우승을 했다.

앞에서 살펴본 왓슨(Watson)과는 달리 알파고의 핵심은 클라우드라는 두뇌이다. 차원이 다른 것이다. 이 클라우드 두뇌에는 1202개의 중앙처리장치(CPU)와 176개의 그래픽처리장치(GPU)가 연결되어 있어, 왓슨과 인간의 1:1 아니라 1378:1 이라는 점이다. 그것도 실시간으로 이 많은 CPU와 GPU를 통해 분석하고 패턴을 찾아 솔루션을 제공하고 있는 것이다. 그러니 패할 수 밖에 없다. 불공정한 게임이다.

딥마인드 개발자 데미스 하사비스(Demis Hassabis) 부사장은 "바둑은 경우의 수가 우주에 존재하는 원자 수보다 많다. 바둑은 체스와 비교할 때 경우의 수가 10의 100제곱 이상 많아 컴퓨팅화 하기 어려운 대상"이라고 말했다. 그만큼 바둑은 인공지능 알고리즘을 빠르고 효율적으로 개발하고 시험해볼 수 있는 좋은 플랫폼이라는 것이다.

알파고에는 프로 바둑기사가 실제로 둔 16만 건의 기보 데이터를 확보해 3000만 개 이상의 착점을 학습했다. 그런 다음 4주 연속 단 1초도 쉬지 않고 알파고는 학습했다. 알파고를 개발한 데이비드 실버(David Silver)는 "알파고가 바둑을 학습한 시간을 인간의 시간으로 환산하면 약 1000년의 세월"이라고 설명했다. 사람이면 1000년 걸리는 100만 번의 대국을 4주만에 소화했다는 의미이다.

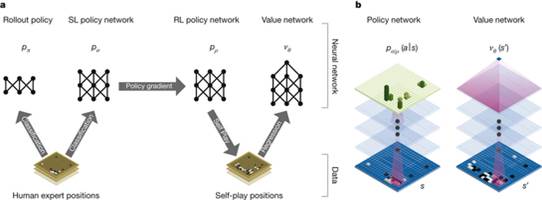

알파고의 딥러닝 알고리즘은 2016년 1월 28일자의 Nature지에 논문으로 발표됐다(David Silver, Demis Hassabis et al., Nature, 28 Jan 2016)14). 알파고가 사용한 것은 바둑판의 위치를 판단하는 가치 네트워크(Value networks)와 어디를 두어야 할지를 선택하는 폴리쉬 네트워크(Policy networks)로 구성된 딥뉴럴네트워크(Deep Neural Networks, DNN)이다. 이 DNN을 학습시키는 방법에는 사람에 의한 지도학습(Supervised learning)과 데이터 기반의 비지도학습(Unsupervised learning)이 있다.

14) David Silver, Demis Hassabis et al., 'Mastering the game of Go with deep neural networks and tree search', Nature, Vol. 529, No. 7587, pp. 484-489, doi:10.1038/nature16961(28 Jan 2016)

www.nature.com/nature/journal/v529/n7587/full/nature16961.html

그런데 이번에 알파고의 DNN은 전문 바둑기사들(human expert games)에 의한 지도학습과 스스로 바둑 게임(self-play)을 하면서 배우는 강화 학습(reinforcement learning)이라는 새로운 콤비라는(a novel combination) 방식으로 학습했다. 결국 사람에 의한 지도학습의 폴리쉬 네트워크(SL. policy network)로 먼저 학습을 하고, 그 이후에 스스로 하는 강화학습 폴리쉬 네트워크(RL. policy network)를 통해 가치 네트워크(Value networks)와 폴리쉬 네트워크(Policy networks)를 구성한 것이다. 그 결과 이 DNN은 스스로 바둑 게임을 하면서 수천 건의 게임을 시뮬레이션하는 몬테칼로 나무서치 프로그램(Monte Carlo tree search programs)의 수준에 올랐다.

〈그림 8〉 David Silver, Demis Hassabis et al., Nature(28 Jan 2016)

또한 몬테칼로 시뮬레이션과 가치 네트워크와 폴리쉬 네트워크를 합쳐 새로운 서치 알고리즘(Search algorithm)도 개발했다. 이 새로운 서치 알고리즘을 이용해, 알파고의 DNN은 다른 유사한 인공바둑프로램들을 대상으로 게임한 결과 승률이 99.8%에 달했으며, 결국 유럽 챔피언인 판후이(Fan Hui) 2단을 올 1월에 5:0으로 이길 수 있었고(Youtube, 27 & 28 Jan 2016)15), 3월 9일에는 이세돌 9단과의 1국에서 승리를 할 수 있었다.

15) Youtube via 연합뉴스, '바둑기사 이긴 인공지능…'명인'도 이길까?'(28 Jan 2016)

www.youtube.com/watch?v=kmdwsXUVnMk

Youtube, 'Google DeepMind: Ground-breaking AlphaGo masters the game of Go'(27 Jan 2016)

www.youtube.com/watch?v=SUbqykXVx0A

그런데 이게 어떤 의미가 있느냐는 것이다. 설사 알파고가 이세돌 9단을 5:0으로 완승했다고 치자. 이것이 어떤 새로운 비즈니스 창출에 어떤 도움을 줄 수 있느냐는 것이다. 그저 하나의 이벤트요 게임일 뿐 아무런 의미가 없다는 것이다. 이것은 인공지능이 이제 시작일 뿐이라는 것을 의미하는 것이다. 인간을 게임에서 이기고 인간과 대적하여 이기는 인공지능이 아니라 인간이 꿈을 꿀 수 없는 꿈을 대신 꿔주고 그것을 비전과 전략으로 그려주고 인간을 돕는 그러한 인공지능을 개발해야 한다는 것이다. 갈 길이 멀다는 의미이다.

4. 엘론 머스크가 이끄는 Open AI.Com

와이 컴비네이터(Y Combinator)의 샘 알트만(Sam Altman) 사장, 테슬라와 스페이스엑스(SpaceX)의 엘론 머스크(Elon Musk) 회장, 링크트인(LinkedIn)의 리드 호프먼(Reid Hoffman) 회장, 아이콘을 창안한 피터 틸(Peter Thiel), 작가이자 와이 컴비네이터의 공동창업자인 제시카 리빙스톤(Jessica Livingston), 아마존 웹서비스(AWS), 인포시스(Infosys), YCR Research 등이 기업 후원자로 참여하고 총 10억 달러를 후원하여 2015년 12월 11일에 OpenAi.com(openai.com/blog/introducing-openai)을 설립했다. 샘 알트만(Sam Altman)과 엘론 머스크(Elon Musk)가 공동 의장을 맡는다.

이 기관의 초대 연구소장은 머신 러닝(ML) 분야 전문가인 일리야 수츠케버(Ilya Sutskever, www.cs.toronto.edu/~ilya)가 맡는다. 그는 구글의 브레인 팀(Brain Team)에서 3년간 연구 과학자(Research Scientist)로 일했으며, DNNResearch의 공동창업자이다. 그는 스탠포드대의 세계적 딥 러닝(DL)의 전문가인 앤드류 응(Andrew Ng, 2014년 5월에 중국의 바이두가 영입)의 그룹에서 박사 후 연구를 했으며, 대학 시절에는 토론토대의 세계적 딥 러닝 전문가인 제프리 힌튼(Geoffrey Hinton, 2013년부터 구글에 합류)으로부터 기계학습(Machine Learning)을 배웠다. 다시 말해 세계적 ML-DL의 전문가들인 앤드류 응과 제프리 힌튼의 수제자라는 점이다. 스트라이프(Stripe)의 전 CTO인 그렉 브록크만(Greg Brockman, twitter.com/gdb)이 CTO를 맡는다.

창립연구진은 총 7명인데, Y Combinator의 파트너인 블랙웰(Trevor Blackwell), 플렛폼 API 엔지니어인 청(Vicki Cheung), 스탠포드대 박사과정생인 카패씨(Andrej Karpathy), 암스텔담대학의 박사과정생인 킹마(Durk Kingma), 유씨버클리대 박사과정생인 슐만(John Schulman), 페이스북의 AI 연구원인 바가타(Pamela Vagata), 그리고 뉴욕대학의 박사과정생이며 페이스북의 AI 인턴인 자렘바(Wojciech Zaremba)가 연구원으로 일을 한다.

연구원 7명

www.trevorblackwell.com/#

vickicheung.com

s.stanford.edu/people/karpathy

dpkingma.com

www.eecs.berkeley.edu/~joschu

www.linkedin.com/in/pamela-vagata-8396074

cs.nyu.edu/~zaremba

오픈AI의 장기 목표는 인간이 의지와 사고력으로 할 수 있는 일이면 뭐든지 할 수 있는 범용 인공지능을 만드는 것이다. 다만 인간을 대체하는 것이 아니라 인간의 모자라는 점을 보충할 수 있는 이타적 기술을 개발하는 데 주력할 방침이다. 또한 AI의 파국(A.I. apocalypse)을 사전에 막는 솔루션도 연구한다. 엘론 머스크는 AI가 인간을 파국으로 몰고 갈 것이라며 그간 반대를 해왔는데, 이제는 긍정적인 면으로 돌아섰다는데 의미가 있다.

“인간 수준의 AI가 얼마나 사회에 기여를 할 것인지 알아내는 것은 어렵습니다. 마찬가지로 AI가 구축되고 부적절하게 사용되었을 때 사회에 얼마나 해를 주는지 상상하는 것도 어렵습니다. 우리의 연구가 재정 의무 혹은 부채로부터 자유롭기 때문에, 우리는 인간에게 긍정적인 영향을 주는데 보다 집중할 수 있습니다. 우리는 AI가 각 개인의 의지의 확장에 초점을 맞추어야 한다고 믿습니다. 그리고 자유의 영혼에 입각하여, 누구나 넓게 공평하게 사용할 수 있도록 유통되어야 하고 가능한 안전해야 한다고 믿습니다(It’s hard to fathom how much human-level AI could benefit society, and it’s equally hard to imagine how much it could damage society if built or used incorrectly. Since our research is free from financial obligations, we can better focus on a positive human impact. We believe AI should be an extension of individual human wills and, in the spirit of liberty, as broadly and evenly distributed as is possible safely.)”

AI는 항상 놀라운 영역으로 자리 매김하고 있다. 처음 등장했을 때 사람들은 AI가 어떤 작업, 예컨데 체스 게임에서 인간을 이김으로써, 인간과 같은 수준의 지능 알고리즘(intelligence algorithms)을 곧 발견하게 될 것이라 믿었다. 그렇지만 그 결과는 우리가 희망하는 것보다 훨씬 낮은 수준이었다.

최근에서야 딥 러닝 덕분에 데이터와 이미지들에서 사물과 사람을 인식하고, 기계가 번역을 해주며, 인간과 쌍방향으로 대화할 수 있는 음성인식도 가능해 졌다. 그러나 이것이 인간에게 무슨 의미가 있는가? 지도학습의 사진 천장을 보여주고 동영상 천 개를 보여주어 ML-DL로 하여금 고양이를 분별해내는 이 훈련이 무슨 의미가 있는가? 페이스북의 AI 시스템은 사진의 이미지들을 구별해 세그먼트와 카테고리로 나눌 때 10배나 적은 빅 데이터를 사용하지만 기존의 방식보다 30%나 빠르다는데, 이것이 무슨 의미가 있는가? 구글의 클라우드 로봇이 바나나를 인식하고 안경을 인식하고 돈을 인식하는데, 이것이 무슨 의미가 있는가? 인간의 눈으로 보면 금방 알 수 있지 않는가? 다시 말해 이 정도의 수준으로 무슨 새로운 비즈니스가 창출 될 것인가?

이러한 관점에서 Open AI는 다른 곳을 향하고 있다. 바로 AI-ML-DL로 하여금 ▲ 그림을 모방할 수 있는 창의적이고(to be creative), ▲ 인간이 꾸지 못하는 꿈을 꾸고 그것을 그려주며 (to dream), ▲ 이 세상을 인간과 같이 경험하도록 하는 것이다(and to experience the world). 현재까지 발표된 자료에 의하면 말이다.

이 세 가지의 초기적인 사례들을 살펴보자. 우선 창의적이란 무엇인지를 보자. 영국 와이얼드는 인공지능 알고리즘이 60분 만에 반 고호의 작품을 모방해 100% 그대로 그려내는데 성공했다고 보도했다.

▲ To be Creative, Wired UK - This algorithm can create an imitation Van Gogh in 60 minutes(01 Sep 2015).

www.wired.co.uk/news/archive/2015-09/01/art-algorithm-recreates-paintings

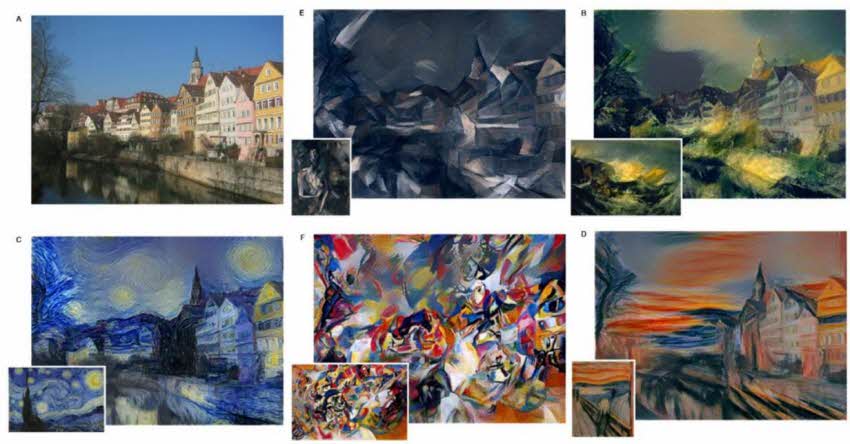

〈그림 9〉독일의 튀빙겐대(University of Tuebingen)의 박사과정 학생들이 개발한 나선형신경망망(convolutional neural network)의 DNN(Deep Neural Network)을 이용해 다양한 이미지들을 변환하여 피카소(Picasso)나 반 고호(Van Gogh)의 작품을 1시간 만에 모방하여 그려내는 인공지능(Gatys, Ecker & Bethge, arxiv, 2 Sep 2015)16)을 개발해 논문으로 제출했다. 이렇듯 인공지능이 예술가를 대체하는 것이 아니라 예술가를 지원하여 한 달에 수십 장의 그림을 그릴 수 있도록 도와주는 인공지능을 개발해야 한다. Image Credit: University of Tuebingen via Wired.co.uk(01 Sep 2015)

16) Gatys, Ecker & Bethge, "A Neural Algorithm of Artistic Style", arXiv:1508.06576 or arXiv:1508.06576v2, at arxiv, Submitted on 26 Aug 2015 (v1), last revised 2 Sep 2015 (this version, v2). arxiv.org/abs/1508.06576

논문을 쓴 독일의 튀빙겐대의 박사과정 학생들인 Leon A. Gatys, Alexander S. Ecker, Matthias Bethge의 연락처 참조(bethgelab.org/people).

이번엔 꿈을 꾸는 인공지능을 보자. 인공지능 컴퓨터가 꾸는 꿈, 컴퓨터가 꿈을 꾼다면 어떤 환상을 그릴까? 가디언은 구글의 안드로이드가 전기 양(electric sheep)의 꿈을 꾸고 그려낼 수 있다고 보도했다.

▲ To Dream, The Guardian - Yes, androids do dream of electric sheep(18 Jun 2015)

www.theguardian.com/technology/2015/jun/18/google-image-recognition-neural-network-androids-dream-electric-sheep

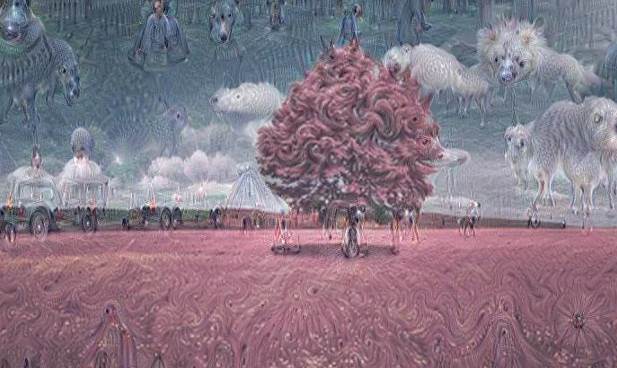

구글의 이미지인지신경망(Image Recognition Neural Network)을 이용해 그림에서 패턴을 찾아 그 주변환경에 맞는 동물, 빌딩, 배경 등의 환상적인 이미지(hallucinatory images)를, 아름다움에서 공포에 이르기까지의 전자 그림을 그려내는데 성공했다고 보도했다.

〈그림 10〉빨간 나무를 필터링하여 주변환경에 어울리는 환상적인 동물들을 그려낸 구글의 이미지인지신경망. 출처: Google

지금은 이러한 수준이지만, 만약에 인간과 같이 하는 인공지능이라면, 여러분의 꿈을 말로 얘기하면, 인공지능이 그 꿈을 그림으로 그려 나타내고(1안과 2안), 선택하면 그것을 비전으로 나타내고, 구체적인 목표와 전략으로 제시한다고 생각해보라. 문제를 말하면 그 문제를 푸는 솔루션을 제시한다고 생각해보라. 바로 이러한 인공지능을 개발해야 하는 것이다.

다시 한번 꿈을 그리는 사례를 보자. 구글은 2015년 6월 18일에 "인셉셔니즘(Inceptionism)은 신경망이 어떻게 작동하는지 이해하고 시각화하는데 도움을 준다"며 "인공신경망이 예술가를 위한 도구가 될 수 있지 않을까 생각한다"고 밝힌바 있다(Google, 18 Jun 2015).

▲ To Dream, Google - Inceptionism: Going deeper into Neural Networks(18 Jun 2015)

photos.google.com/share/AF1QipPX0SCl7OzWilt9LnuQliattX4OUCj_8EP65_cTVnBmS1jnYgsGQAieQUc1VQWdgQ?key=aVBxWjhwSzg2RjJWLWRuVFBBZEN1d205bUdEMnhB,

googleresearch.blogspot.kr/2015/06/inceptionism-going-deeper-into-neural.html

〈그림 11〉도시의 무작위 소리를 감지해 어떻게 미래의 도시를 건설하라고 제안한 도시의 꿈을 그려낸 인공지능. 출처: Google

자 이번엔 마지막으로 ‘이 세상을 인간과 같이 경험하도록 하는 것이다(and to experience the world)’의 사례를 보자. 블름버그는 유치원에서 3살 배기 아이들과 인공지능 로봇(Brett)이 레고블록(Lego blocks) 쌓기와 맞추기 등을 교실에서 함께 배우는 예를 보도했는데, 아이들이 인공지능과 쌍방향으로 서로 가르치고 학습하는 것이다. 이 인공지능 로봇(Brett)은 유씨버클리대(University of California at Berkeley)가 개발한 것으로 심화학습과 강화학습(deep learning and reinforcement learning)이라는 알고리즘의 AI 기술이 적용됐다.

▲ To Experience the World, Bloomberg - This Preschool Is for Robots(02 Sep 2015)

www.bloomberg.com/features/2015-preschool-for-robots

〈그림〉인공지능 로봇(Brett)이 3살 배기 아이들과 간단한 레고블록 맞추기를 연습하고 있다. 출처: Molly Matalon and Damien Maloney for Bloomberg Businessweek

5. ELSI와 FLI

인공지능 발전이 인류에 가져올 위험을 연구하고, 사전에 대비하기 위한 연구 활동이 본격적으로 이루어지고 있다. 이러한 연구와 평가를 ELSI(Ethic, Legal or Law, Social Impact) 영향과 평가라고 하는데, 이외에 정책(Policy), 경제(Economic), 기술(Technology), 환경(Environment), 에너지(Energy), 그리고 인간의 가치(Value) 등을 추가할 수 있다.

그간 빌 게이츠(Bill Gates) 회장, 엘론 머스크(Elon Musk) 회장, 스티븐 호킹(Stephen Hawking) 박사 등이 한 목소리로 인공지능이 뜻하지(unintended) 않은 방향으로 발전한다면 인간은 파국(disastrous)을 맞을 것이라고 경고를 해왔다(The program launches as an increasing number of high-profile figures including Bill Gates, Elon Musk and Stephen Hawking voice concerns about the possibility of powerful AI systems having unintended, or even potentially disastrous, consequences)17).

17) Future of Life, 2015 Selection(1 July 2015), futureoflife.org/2015selection

이에 따라 역시 발 빠르게 움직이는 나라가 미국이다. 미국 보스톤 소재 비영리 연구단체인 퓨처 오브 라이프 인스티튜트(Future of Life Institute, 이하 FLI, http://futureoflife.org/)는 현재 떠 오르고 있는 제4차 산업혁명인 인공지능(AI)과 생명공학(Biotech), 그리고 핵(Nuclear)과 기후(Climate)를 연구하는 단체이다.

특히 인공지능을 보면 FLI의 연구 우선순위와 목적은 간단하다. 가능한 파국(avoiding potential pitfalls)을 막고, 인간에게 선(善)하고 혜택을 줄 수 있는 그러한 인공지능을 개발하는데(keeping AI robust and beneficial) 필요한 연구를 하자는 것이다. 지금 연구하는 것이 매우 중요하고 시기 적절하다는 것이다. 그리고 이러한 취지의 공개서한을 만들고, 많은 사람들에게 오픈하여 동참을 유도하고 있다18).

18) Future of Life, 'Research priorities for robust and beneficial artificial intelligence'

http://futureoflife.org/ai-open-letter

http://futureoflife.org/data/documents/research_priorities.pdf

엘론 머스크 회장, 스티븐 호킹 박사를 비롯하여, 페이스북의 인공지능연구소(FAIR, research.facebook.com/ai)의 소장인 얀 레쿤(Yann LeCun), 캐나다 코론토대 교수이자 구글에서 인공지능을 연구하고 있는 제프리 힌튼(Geoffrey Hinton), 구글이 인수한 영국의 딥마인드(DeepMind) 개발자이며 알파고(AlphaGo)를 개발한 데미스 하사비스(Demis Hassabis), OpenAI.com의 초대 연구소장인 일리야 수츠케버(Ilya Sutskever) 등 인공지능을 직접 개발하는 연구자들과 지금까지 이들을 포함하여 전 세계의 8,600명이 이에 동참하여 공개서한에 사인을 했다.

그런데 2015년 1월에 획기적인 선한 사건이 발생했다. 테슬라와 스페이스X의 회장인 엘론 머스크가 FLI에 1,000만 달러(약 120억)를 기부한 것이다. 선하고 혜택을 줄 수 있는 인공지능을 개발하자면 무엇을 어떻게 해야 하는지, 즉 ELSI 연구에 필요한 자금을 지원한 것이다19). 이를 계기로 많은 사람들이 기부(Open Philanthropy)를 하기 시작하여 지금은 연구자금이 1,100만 달러에 이르고 있다.

19) Future of Life, 'Elon Musk donates $10M to keep AI beneficial'(15 Jan 2015)

futureoflife.org/2015/10/12/elon-musk-donates-10m-to-keep-ai-beneficial

그 이후 FLI는 1,100만 달러(Elon Musk and the Open Philanthropy Project) 중 700만 달러(약 84억)를 2015년에 집행하기 위해 전세계의 관련기관들에서 연구주제를 제안 받았는데, 무려 300개를 받았으며, 전문가들의 지독한 심사를(a grueling expert review) 거쳐 윤리 분야, 컴퓨터 사이언스 분야, 법 분야, 경제 분야, 기타 분야 등 총 37개 팀을 선발하였다20). 37개 팀들은 2015년 9월부터 앞으로 3년간 연구하게 된다.

20) Future of Life, 'And the winners are…'(1 Jul 2015)

futureoflife.org/2015/07/01/and-the-winners-are

37개 팀들이 제안한 것 중 주요 내용을 보면,

(1) 3개가 AI 시스템을 위한 기술 개발 제안으로, 궁극적으로는 AI로 하여금 인간의 행동들 중 인간이 좋아하는 행동을 배우도록 하는 것으로 UC Berkeley와 Oxford University 에서 수행한다.

(2) 1개는 MIRI(Machine Intelligence Research Institute)의 Benja Fallenstein이 제안한 것으로 어떻게 하면 초지능 시스템이 인간의 가치들(human values)과 조율하고 일치시키느냐 이다.

(3) 1개는 카네기 멜론대의 Manuela Veloso이 제안한 것으로 인간들에게 의사결정을 제안하는 AI 시스템을 개발하는 것이다.

(4) 1개는 스탠포드대의 Michael Webb이 제안한 것으로 선하고 혜택을 주는 인공지능을 개발할 경우 경제에 미치는 영향이다.

(5) 1개는 Heather Roff가 제안한 것으로 인간이 제어할 수 있는 조건에서 AI가 탑재된 무기를 어떻게 만드느냐이다.

(6) 최대 금액인 150만 달러를 받은 옥스퍼드는 AI 전략 리서치 센터(Strategic Research Center for Artificial Intelligence) 설립을 제안했다.

(7) 듀크대의 Vincent Conitzer는 인공지능에 윤리를 어떻게 구축할 것인가를 제안했다.

(8) 4개 기관은 AI 관련 컨퍼런스와 교육을 제안하였고, 이 밖에 많은 연구 프로젝트가 각 분야에서의 노력에 대해 10만 달러 단위의 금액을 획득했다.

기타 자세한 37개 기관들이나 개인들의 연구주제와 담당자의 이맬은 다음 사이트를 참조하라20).

20) Future of Life, '2015 PROJECT GRANTS RECOMMENDED FOR FUNDING'(1 Jul 2015)

futureoflife.org/first-ai-grant-recipients

futureoflife.org/2015/10/12/11m-ai-safety-research-program-launched

6. 시사점

지금까지 살펴본 결과, 인공지능은 이제 시작이라는 것이다. 왜냐하면 지금의 인공지능 알고리즘은 인간의 신경망을 모방하는 것이어서, 신경세포와 시냅스와 비신경세포로 이루어진 인간의 두뇌를 따라오기란 그리 쉽지 않기 때문이다. 이것만이 아니다.

신경세포와 비신경세포 안에 들어 있는 유전자, 유전자가 생산하는 단백질, 히스톤(Histone) 변형 등의 후성유전(Epigenome), 신진대사, 환경 등에 따라 항상성(Homeostasis)과 의사결정이 바뀐다. 따라서 인간의 뇌는 이러한 여러 변수들에 따라 물리적인 구조를 자유롭게 바꿔가며 정보를 입력하기 때문에, 지금의 신경망 알고리즘에 한 차원 높은 다른 알고리즘들이 융합되지 않는 한 갈 길이 먼 것이다. 설사 여러 알고리즘들이 융합된다 해도 그것은 끝이 아니라 또 다른 시작일 뿐이다.

그렇다고 주저 앉자는 얘기가 아니다. 이제 시작이라는데 의미가 있는 것이다. 인공지능이 적용되는 분야는 무궁무진하기 때문이다. 국방, 교육, 행정, 교통(자율차), 두뇌인터넷, 생체인터넷(웨어러블), 로봇, 드론, SNS, 증강/가상현실, 음성개인비서, 핀테크 등 인공지능이 안 들어가는 분야가 없기 때문이다. 사실 인공지능은 1956년에 시작되었지만, 1980년까지 첫 번째 부침, 1990년 초에 두 번째 부침을 겪었다. 그리고 2000년 중반부터 다시 불을 지 피우고 있다.

그런데, 60년(환갑)이 흐른 뒤, 이번에는 좀 다르다. 인공지능이 전문가 집단의 소유가 아니라 일반인도 참여하는 오픈 소스로 지향하고 있기 때문이다. 인터넷과 모바일의 발전에 따라 일반인들이 네트워크에 연결되고 협력하는 상황이다. 인공지능은 순수한 소프트웨어 기술만이 아니라 일반인들의 참여를 유도하는 경우 더 뛰어난 개선이 이루어지기도 하고, 사람들이 이미 작성한 지적 활동의 결과를 활용할 수 있다. 수십억의 사람들이 연결되어서 작은 활동을 하고, 이를 인공지능 기술이 효과적으로 활용하면 더 뛰어난 결과를 얻을 수 있다.

그래서 작년 말부터 올 초까지 페이스북이 제일먼저 딥러닝 모듈과 머신 러닝 하드웨어인 빅서(Big Sur)를 오픈 소스로 공개했으며, 이어서 구글도 머신 러닝 기술인 텐서플로우(TensorFlow)와 클라우드 비전(Cloud Vision) API를, 이어서 마이크로소프트도 프로젝트 옥스포드(Oxford)와 툴 킷인 DMTK를 오픈 소스로 공개했는데, 공개한 이유가 여기에 있으며, 또한 또 다시 부침을 막자는데 있다.

마지막으로 인공지능을 부정적이 아닌 긍정적인 관점으로 보아야 한다. 그간 인공지능에 반대입장을 표명했던 엘론 머스크도 작년 말에 오픈에아이(OpenAi)를 설립해서, 인공지능이 일자리를 대체하는 것이 아니라 일자리를 더욱 많이 창출하는 방법을 연구하기 시작했다. 인공지능이 사람을 도와 보다 창의적인 아이디어를 만들어주고, 사람이 꿀 수 없는 꿈을 대신 꿔서 그 꿈의 비전과 전략을 그려주며, 아이들과 함께 놀고 학습하는 그러한 인공지능을 개발해야 한다.

세계경제포럼의 보고서가 다소 과장된 부분이 없지 않지만, 우리에게 주는 경고라는 메시지로 받아들여, 이제부터 시작한다는 출발점에서, 미국의 FLI처럼 ELSI 사전연구를 통한 정책과 전략을 수립해 집중 연구개발해야 할 것이다. 다행히 미래창조과학부는 2016년 3월에 인공지능 기술개발과 관련 산업 육성을 위해 앞으로 5년간 1조원에 가까운 예산을 투자하기로 했다. 이와 함께 정부는 민간기업들이 주도하는 '지능정보기술연구소'를 설립한다고 밝혔다. 투자와 연구소 설립이 중요한 것이 아니라 우리가 잘 할 있는 기초분야와 응용분야를 선택해 집중 연구개발해야 할 것이다.

<저작권자(c)스마트앤컴퍼니. 무단전재-재배포금지>